联邦学习白皮书 V1.0

1

2018

... 随着计算机算力的提升,机器学习作为海量数据的分析处理技术,已经广泛服务于人类社会.然而,机器学习技术的发展过程中面临两大挑战:一是数据安全难以得到保障,隐私数据泄露问题亟待解决;二是网络安全隔离和行业隐私,不同行业、部门之间存在数据壁垒,导致数据形成“孤岛”无法安全共享[1],而仅凭各部门独立数据训练的机器学习模型性能无法达到全局最优化. ...

联邦学习白皮书 V1.0

1

2018

... 随着计算机算力的提升,机器学习作为海量数据的分析处理技术,已经广泛服务于人类社会.然而,机器学习技术的发展过程中面临两大挑战:一是数据安全难以得到保障,隐私数据泄露问题亟待解决;二是网络安全隔离和行业隐私,不同行业、部门之间存在数据壁垒,导致数据形成“孤岛”无法安全共享[1],而仅凭各部门独立数据训练的机器学习模型性能无法达到全局最优化. ...

Communication-efficient learning of deep networks from decentralized data

5

2017

... 为了解决以上问题,谷歌提出联邦学习[2](FL, federated learning)技术,其通过将机器学习的数据存储和模型训练阶段转移至本地用户,仅与中心服务器交互模型更新的方式有效保障了用户的隐私安全.作为网络安全领域新的研究热点,联邦学习吸引了大量关注与研究.为了更加深入地展开研究,本文主要对现有研究成果做初步的梳理和总结,对典型方案进行详细分析与比较,指出它们的优势与不足,并结合边缘计算、区块链、5G 等新兴技术对联邦学习的应用前景和研究热点进行展望[3]. ...

... 传统的机器学习算法需要用户将源数据上传到高算力的云服务器上集中训练,这种方式导致了数据流向的不可控和敏感数据泄露问题.Mcmahan等在2016年提出联邦学习技术[2],允许用户在机器学习过程中既可以保护用户隐私,又能够无须源数据聚合形成训练数据共享. ...

... 联邦学习与分布式计算的区别是联邦学习的数据集来自各个终端用户,这些用户产生的数据特征往往呈非独立同分布(Non-IID).Non-IID指的是在概率统计理论中,各数据集中的随机变量不服从同一分布,即对于不同的客户端i和j,它们的数据集概率分布Pi ≠ Pj.而传统的分布式框架算法只有在处理独立同分布(IID)数据时表现良好,而在处理 Non-IID 数据时会造成训练过程难以收敛、通信轮数过多等问题[2,11].另外,在互联网环境中,大量本地模型的更新、上传会导致中心服务器通信开销过大,无法满足正常的应用要求,同时相邻的模型更新中可能包含许多重复更新或者与全局模型不相关的更新[12]. ...

... 综上,联邦学习的通信效率优化具有重要的研究意义.通常改进方案有两个目标:减少每轮通信传输的数据大小;减少模型训练的总轮数.目前,改进通信效率方案主要是通过优化联邦学习框架算法、压缩模型更新和采用分层分级的训练架构.这些方案一定限度上提升了联邦学习模型训练速度、减小了数据通信量,对联邦学习技术的完善具有重大意义,但现阶段仍然存在许多难以解决的问题.例如,优化算法在处理Non-IID数据时相对于处理IID数据的时间开销成倍增长[2];压缩算法虽然能够显著降低通信数据大小,但同时会严重影响模型精度,在通信效率和模型精度之间的平衡成为挑战[11,13];分层分级的训练架构也不适合于所有的联邦学习场景,有时这种物理结构并不存在. ...

... 在分布式计算框架中,客户端每运行一次SGD算法训练,机器学习模型就会向中心服务器上传本轮产生的本地模型更新.但是,频繁的通信交互会对参与训练各方造成不必要的通信负担.McMahan等[2]针对联邦学习的低带宽环境提出FedAvg算法,要求客户端在本地多次执行SGD算法,然后与中心服务器交互模型更新,实现用更少的通信轮数训练出相同精度的模型.相比于基准算法 FedSGD[30],其在训练不同神经网络的通信轮数上减少了 1%~10%,但该算法对于非凸问题没有收敛保证,在非 IID 数据集上难以收敛[31]. ...

AI与数据隐私保护:联邦学习的破解之道

2

2019

... 为了解决以上问题,谷歌提出联邦学习[2](FL, federated learning)技术,其通过将机器学习的数据存储和模型训练阶段转移至本地用户,仅与中心服务器交互模型更新的方式有效保障了用户的隐私安全.作为网络安全领域新的研究热点,联邦学习吸引了大量关注与研究.为了更加深入地展开研究,本文主要对现有研究成果做初步的梳理和总结,对典型方案进行详细分析与比较,指出它们的优势与不足,并结合边缘计算、区块链、5G 等新兴技术对联邦学习的应用前景和研究热点进行展望[3]. ...

... 本文介绍了联邦学习技术概念、算法原理与分类,并对目前联邦学习中的3个痛点问题的研究进展做出归纳总结,最后展望了联邦学习在各领域的发展前景.随着社会对于隐私安全的日益重视,政府正在逐步加强对私人数据的管控,传统的机器学习模式可能不再符合安全法规.联邦学习作为下一代人工智能大规模协作的基础理论,为目前发展人工智能面临的小数据和隐私等关键问题提供了有效的解决思路.同时,对于联邦学习的国际标准在积极制定中,未来建立在统一标准下的联邦学习必然能够更好地应用于各行各业,发挥更大的效能,进一步推动网络安全的发展[3]. ...

AI与数据隐私保护:联邦学习的破解之道

2

2019

... 为了解决以上问题,谷歌提出联邦学习[2](FL, federated learning)技术,其通过将机器学习的数据存储和模型训练阶段转移至本地用户,仅与中心服务器交互模型更新的方式有效保障了用户的隐私安全.作为网络安全领域新的研究热点,联邦学习吸引了大量关注与研究.为了更加深入地展开研究,本文主要对现有研究成果做初步的梳理和总结,对典型方案进行详细分析与比较,指出它们的优势与不足,并结合边缘计算、区块链、5G 等新兴技术对联邦学习的应用前景和研究热点进行展望[3]. ...

... 本文介绍了联邦学习技术概念、算法原理与分类,并对目前联邦学习中的3个痛点问题的研究进展做出归纳总结,最后展望了联邦学习在各领域的发展前景.随着社会对于隐私安全的日益重视,政府正在逐步加强对私人数据的管控,传统的机器学习模式可能不再符合安全法规.联邦学习作为下一代人工智能大规模协作的基础理论,为目前发展人工智能面临的小数据和隐私等关键问题提供了有效的解决思路.同时,对于联邦学习的国际标准在积极制定中,未来建立在统一标准下的联邦学习必然能够更好地应用于各行各业,发挥更大的效能,进一步推动网络安全的发展[3]. ...

不同数据分布的联邦机器学习技术研究

1

2019

... 其中,dk 是第 k 个客户端的本地数据集, 是具有参数w的模型对数据集,yi)产生的损失函数.dk中所有实dk中的实例(xi例产生的损失函数之和除以客户端k的总数据量就是本地客户端的平均损失函数,损失函数与模型精度成反比,因此,机器学习的目标函数优化通常是让损失函数达到最小值[4]. ...

不同数据分布的联邦机器学习技术研究

1

2019

... 其中,dk 是第 k 个客户端的本地数据集, 是具有参数w的模型对数据集,yi)产生的损失函数.dk中所有实dk中的实例(xi例产生的损失函数之和除以客户端k的总数据量就是本地客户端的平均损失函数,损失函数与模型精度成反比,因此,机器学习的目标函数优化通常是让损失函数达到最小值[4]. ...

Federated machine learning:Concept and applications

2

2019

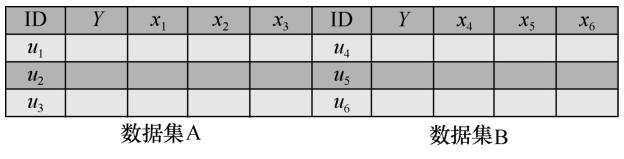

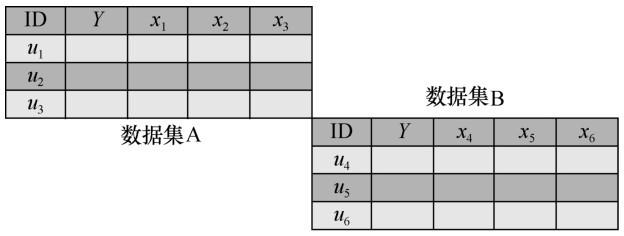

... 联邦学习的应用场景不同,客户端之间持有的数据集特征各不相同.假设Dm代表客户端 m持有的数据,I 表示样本 ID,Y 表示数据集的标签信息,X 表示数据集的特征信息,因此,一个完整的训练数据集D应由(I,Y,X)构成.根据参与训练客户端的数据集特征信息X的不同,联邦学习被分为横向联邦学习、纵向联邦学习和联邦迁移学习[5]. ...

... 联邦迁移学习被用于解决标签样本少和数据集不足的问题[5],如中国的电商平台与其他国家银行之间的数据迁移,由于跨部门跨国的数据交流很难实现,通过联邦迁移学习可以很好地解决这类痛点问题. ...

Federated learning for mobile keyboard prediction

1

2018

... 在用户输入法数据上训练的下一词预测模型[6]是典型的横向联邦学习应用.不同的手机用户具有相同的数据特征,数百万个安卓手机在云服务器的协调下训练共享的全局模型,其本质是将多方对不同目标的相同特征描述进行训练提取. ...

Abnormal client behavior detection in federated learning

2

2019

... 然而,在模型训练过程中,客户端数量较多,往往容易发生客户端恶意连接企图窃取信息,Li等[7]对此提出基于检测的方法拒绝恶意客户端的接入.同时,该方式需要考虑服务器对客户端模型信息的可见性,针对不可信服务器,Bonawitz等[8-9]引入安全多方计算来保护客户端更新的隐私性. ...

... 在联邦学习环境中,通常有数以万计的设备参与训练,服务器如果无法及时检测恶意客户端,很容易造成全局模型被污染甚至隐私泄露问题.Li等[7]提出基于检测的算法,通过一个预先训练的自动编码器神经网络来检测异常的客户行为,并消除其负面影响,给出各客户端信用评分并拒绝恶意客户端的连接.Zhao[62]等通过在服务器端部署GAN,通过客户端模型参数生成审计数据集,并利用该数据集检查参与者模型的准确性,确定是否存在中毒攻击.实验证明,该方法相比传统的模型反演方法,生成的审计数据集质量更高. ...

Practical secure aggregation for privacy-preserving machine learning

1

2017

... 然而,在模型训练过程中,客户端数量较多,往往容易发生客户端恶意连接企图窃取信息,Li等[7]对此提出基于检测的方法拒绝恶意客户端的接入.同时,该方式需要考虑服务器对客户端模型信息的可见性,针对不可信服务器,Bonawitz等[8-9]引入安全多方计算来保护客户端更新的隐私性. ...

NIKE-based fast privacy-preserving high-dimensional data aggregation for mobile devices

1

2018

... 然而,在模型训练过程中,客户端数量较多,往往容易发生客户端恶意连接企图窃取信息,Li等[7]对此提出基于检测的方法拒绝恶意客户端的接入.同时,该方式需要考虑服务器对客户端模型信息的可见性,针对不可信服务器,Bonawitz等[8-9]引入安全多方计算来保护客户端更新的隐私性. ...

Secureboost:a lossless federated learning framework

1

2019

... 纵向联邦学习中一方掌握训练的标签信息Y,各方通过输入特征信息X,得到纵向全局模型.其典型应用场景如同一地区的银行和电商平台:银行拥有当地用户的收支记录x1,电商平台拥有用户的消费记录和浏览记录x2,双方想通过数据联合对客户信用Y进行评级,从而提供更个性化的服务,其本质是将多方对相同目标的不同特征描述进行训练提取.为防止纵向联邦学习中恶意用户推测出他方私有用户数据,Cheng 等[10]通过RSA和哈希函数确保参与训练的各方只能获得基于各方共有用户特征训练得到的模型. ...

Federated learning:strategies for improving communication efficiency

4

2016

... 在联邦学习网络中,服务器与远程客户端之间往往需要进行不断的通信来交互模型更新信息,动辄万计的客户端很容易对通信网络造成巨大的带宽负担.通常,全局模型训练时间分为数据处理时间和通信传输时间两部分,而随着计算机设备算力的提升,数据处理时间不断降低,联邦学习的通信传输效率变成限制其训练速度的主要因素[11]. ...

... 联邦学习与分布式计算的区别是联邦学习的数据集来自各个终端用户,这些用户产生的数据特征往往呈非独立同分布(Non-IID).Non-IID指的是在概率统计理论中,各数据集中的随机变量不服从同一分布,即对于不同的客户端i和j,它们的数据集概率分布Pi ≠ Pj.而传统的分布式框架算法只有在处理独立同分布(IID)数据时表现良好,而在处理 Non-IID 数据时会造成训练过程难以收敛、通信轮数过多等问题[2,11].另外,在互联网环境中,大量本地模型的更新、上传会导致中心服务器通信开销过大,无法满足正常的应用要求,同时相邻的模型更新中可能包含许多重复更新或者与全局模型不相关的更新[12]. ...

... 综上,联邦学习的通信效率优化具有重要的研究意义.通常改进方案有两个目标:减少每轮通信传输的数据大小;减少模型训练的总轮数.目前,改进通信效率方案主要是通过优化联邦学习框架算法、压缩模型更新和采用分层分级的训练架构.这些方案一定限度上提升了联邦学习模型训练速度、减小了数据通信量,对联邦学习技术的完善具有重大意义,但现阶段仍然存在许多难以解决的问题.例如,优化算法在处理Non-IID数据时相对于处理IID数据的时间开销成倍增长[2];压缩算法虽然能够显著降低通信数据大小,但同时会严重影响模型精度,在通信效率和模型精度之间的平衡成为挑战[11,13];分层分级的训练架构也不适合于所有的联邦学习场景,有时这种物理结构并不存在. ...

... 横向联邦学习中往往有大量的本地客户端,很难保证每个客户端都拥有稳定可靠的网络连接,低质量的通信会严重降低通信速度.Konečný等[11]提出针对本地模型的结构化更新和草图更新算法,客户端被要求在一个低秩或随机掩码后的有限空间中进行模型学习,然后草图更新算法对模型更新进行量化、随机旋转和子采样等压缩操作,该方案被证明在SGD迭代方面显著减慢了收敛速度.在上述基础上,Caldas等[13]将该方法应用于对全局模型更新的压缩中,同时提出Federated Dropout思想优化模型更新,中心服务器随机选择全局模型的更小子集并采用量化、随机旋转和子采样等压缩操作,客户端接收到全局模型后解压缩并进行本地模型训练,从而减少了联邦学习对客户端设备资源的影响,允许培训更高容量的模型,并接触到更多样化的用户.Reisizadeh 等[37]选择将算法优化与压缩的思路结合起来,其提出的FedPAQ算法要求服务器只选择一小部分客户端参与训练,同时客户端减少上传本地模型次数并在上传之前进行量化更新操作减小通信量. ...

CMFL:mitigating communication overhead for federated learning

2

2019

... 联邦学习与分布式计算的区别是联邦学习的数据集来自各个终端用户,这些用户产生的数据特征往往呈非独立同分布(Non-IID).Non-IID指的是在概率统计理论中,各数据集中的随机变量不服从同一分布,即对于不同的客户端i和j,它们的数据集概率分布Pi ≠ Pj.而传统的分布式框架算法只有在处理独立同分布(IID)数据时表现良好,而在处理 Non-IID 数据时会造成训练过程难以收敛、通信轮数过多等问题[2,11].另外,在互联网环境中,大量本地模型的更新、上传会导致中心服务器通信开销过大,无法满足正常的应用要求,同时相邻的模型更新中可能包含许多重复更新或者与全局模型不相关的更新[12]. ...

... 除了对最初的FedAvg算法的各种改进以外,在客户端或者服务器上增加筛选算法也是研究方向之一.Wang等[12]认为客户端上传的本地模型更新中含有大量的冗余和不相关信息,严重占用通信带宽,因此提出CMFL算法,该算法要求客户端筛选本地模型更新与上一轮全局模型的相关度,通过模型梯度正负符号相同的百分比来避免上传达不到阈值要求的本地模型更新,实现通信开销的降低,但该算法建立在客户端按照协议执行的基础上,系统的鲁棒性较弱.Jiang等[36]提出了 BACombo 算法,利用 gossip 协议和 epsilongreedy 算法检查客户端之间随时间变化的平均带宽,最大限度地利用带宽容量,进而加快收敛速度. ...

Expanding the reach of federated learning by reducing client resource requirements

2

2018

... 综上,联邦学习的通信效率优化具有重要的研究意义.通常改进方案有两个目标:减少每轮通信传输的数据大小;减少模型训练的总轮数.目前,改进通信效率方案主要是通过优化联邦学习框架算法、压缩模型更新和采用分层分级的训练架构.这些方案一定限度上提升了联邦学习模型训练速度、减小了数据通信量,对联邦学习技术的完善具有重大意义,但现阶段仍然存在许多难以解决的问题.例如,优化算法在处理Non-IID数据时相对于处理IID数据的时间开销成倍增长[2];压缩算法虽然能够显著降低通信数据大小,但同时会严重影响模型精度,在通信效率和模型精度之间的平衡成为挑战[11,13];分层分级的训练架构也不适合于所有的联邦学习场景,有时这种物理结构并不存在. ...

... 横向联邦学习中往往有大量的本地客户端,很难保证每个客户端都拥有稳定可靠的网络连接,低质量的通信会严重降低通信速度.Konečný等[11]提出针对本地模型的结构化更新和草图更新算法,客户端被要求在一个低秩或随机掩码后的有限空间中进行模型学习,然后草图更新算法对模型更新进行量化、随机旋转和子采样等压缩操作,该方案被证明在SGD迭代方面显著减慢了收敛速度.在上述基础上,Caldas等[13]将该方法应用于对全局模型更新的压缩中,同时提出Federated Dropout思想优化模型更新,中心服务器随机选择全局模型的更小子集并采用量化、随机旋转和子采样等压缩操作,客户端接收到全局模型后解压缩并进行本地模型训练,从而减少了联邦学习对客户端设备资源的影响,允许培训更高容量的模型,并接触到更多样化的用户.Reisizadeh 等[37]选择将算法优化与压缩的思路结合起来,其提出的FedPAQ算法要求服务器只选择一小部分客户端参与训练,同时客户端减少上传本地模型次数并在上传之前进行量化更新操作减小通信量. ...

Protection against reconstruction and its applications in private federated learning

2

2018

... 研究表明,梯度信息会泄露用户的隐私数据[14,15,16,17,18,19,20],攻击者可以通过客户端上传的梯度信息间接推出标签信息和数据集的成员信息.Carlini等[15]从训练用户语言数据的递归神经网络中提取出了用户的敏感数据,如特定的银行卡号.Fredrikson等[16]研究了如何从模型信息中窃取数据隐私,并通过药量预测实验实现了对线性回归模型的反演攻击,获得了患者的敏感信息.Hitaj等[18]用生成对抗网络(GAN)对模型聚合发起攻击,实验结果表明,恶意客户端能够通过产生相似的本地模型更新来窃取用户数据隐私.Gei等[19]证明了从梯度信息重建输入数据的可行性与深度网络架构无关,并将一批输入图像用余弦相似度和对抗攻击的方法恢复出来. ...

... 在联邦学习进程中,恶意客户端能够通过对分布式模型的分析,获得客户端在训练过程中的贡献及数据集信息.Geyer等[21]提出一种针对客户端的差分隐私保护联邦优化算法,实现了对模型训练期间客户端贡献的隐藏,在有足够多客户端参与的情况下,能够以较小的模型性能成本来达到用户级差分隐私.McMahan等[22]同样使用差分隐私加密全局模型更新,证明了如果参与联邦学习的客户端数量足够多,对模型更新信息的加密就会以增加计算量为代价而不会降低模型精度.Bhowmick等[14]利用差分隐私技术,通过限制潜在对手的能力,提供同等隐私保护程度的同时保证了更好的模型性能. ...

The secret sharer:Measuring unintended neural network memorization & extracting secrets

2

2018

... 研究表明,梯度信息会泄露用户的隐私数据[14,15,16,17,18,19,20],攻击者可以通过客户端上传的梯度信息间接推出标签信息和数据集的成员信息.Carlini等[15]从训练用户语言数据的递归神经网络中提取出了用户的敏感数据,如特定的银行卡号.Fredrikson等[16]研究了如何从模型信息中窃取数据隐私,并通过药量预测实验实现了对线性回归模型的反演攻击,获得了患者的敏感信息.Hitaj等[18]用生成对抗网络(GAN)对模型聚合发起攻击,实验结果表明,恶意客户端能够通过产生相似的本地模型更新来窃取用户数据隐私.Gei等[19]证明了从梯度信息重建输入数据的可行性与深度网络架构无关,并将一批输入图像用余弦相似度和对抗攻击的方法恢复出来. ...

... [15]从训练用户语言数据的递归神经网络中提取出了用户的敏感数据,如特定的银行卡号.Fredrikson等[16]研究了如何从模型信息中窃取数据隐私,并通过药量预测实验实现了对线性回归模型的反演攻击,获得了患者的敏感信息.Hitaj等[18]用生成对抗网络(GAN)对模型聚合发起攻击,实验结果表明,恶意客户端能够通过产生相似的本地模型更新来窃取用户数据隐私.Gei等[19]证明了从梯度信息重建输入数据的可行性与深度网络架构无关,并将一批输入图像用余弦相似度和对抗攻击的方法恢复出来. ...

Privacy in pharmacogenetics:an end-to-end case study of personalized warfarin dosing

2

2014

... 研究表明,梯度信息会泄露用户的隐私数据[14,15,16,17,18,19,20],攻击者可以通过客户端上传的梯度信息间接推出标签信息和数据集的成员信息.Carlini等[15]从训练用户语言数据的递归神经网络中提取出了用户的敏感数据,如特定的银行卡号.Fredrikson等[16]研究了如何从模型信息中窃取数据隐私,并通过药量预测实验实现了对线性回归模型的反演攻击,获得了患者的敏感信息.Hitaj等[18]用生成对抗网络(GAN)对模型聚合发起攻击,实验结果表明,恶意客户端能够通过产生相似的本地模型更新来窃取用户数据隐私.Gei等[19]证明了从梯度信息重建输入数据的可行性与深度网络架构无关,并将一批输入图像用余弦相似度和对抗攻击的方法恢复出来. ...

... [16]研究了如何从模型信息中窃取数据隐私,并通过药量预测实验实现了对线性回归模型的反演攻击,获得了患者的敏感信息.Hitaj等[18]用生成对抗网络(GAN)对模型聚合发起攻击,实验结果表明,恶意客户端能够通过产生相似的本地模型更新来窃取用户数据隐私.Gei等[19]证明了从梯度信息重建输入数据的可行性与深度网络架构无关,并将一批输入图像用余弦相似度和对抗攻击的方法恢复出来. ...

Exploiting unintended feature leakage in collaborative learning

1

2019

... 研究表明,梯度信息会泄露用户的隐私数据[14,15,16,17,18,19,20],攻击者可以通过客户端上传的梯度信息间接推出标签信息和数据集的成员信息.Carlini等[15]从训练用户语言数据的递归神经网络中提取出了用户的敏感数据,如特定的银行卡号.Fredrikson等[16]研究了如何从模型信息中窃取数据隐私,并通过药量预测实验实现了对线性回归模型的反演攻击,获得了患者的敏感信息.Hitaj等[18]用生成对抗网络(GAN)对模型聚合发起攻击,实验结果表明,恶意客户端能够通过产生相似的本地模型更新来窃取用户数据隐私.Gei等[19]证明了从梯度信息重建输入数据的可行性与深度网络架构无关,并将一批输入图像用余弦相似度和对抗攻击的方法恢复出来. ...

Deep models under the GAN:information leakage from collaborative deep learning

2

2017

... 研究表明,梯度信息会泄露用户的隐私数据[14,15,16,17,18,19,20],攻击者可以通过客户端上传的梯度信息间接推出标签信息和数据集的成员信息.Carlini等[15]从训练用户语言数据的递归神经网络中提取出了用户的敏感数据,如特定的银行卡号.Fredrikson等[16]研究了如何从模型信息中窃取数据隐私,并通过药量预测实验实现了对线性回归模型的反演攻击,获得了患者的敏感信息.Hitaj等[18]用生成对抗网络(GAN)对模型聚合发起攻击,实验结果表明,恶意客户端能够通过产生相似的本地模型更新来窃取用户数据隐私.Gei等[19]证明了从梯度信息重建输入数据的可行性与深度网络架构无关,并将一批输入图像用余弦相似度和对抗攻击的方法恢复出来. ...

... [18]用生成对抗网络(GAN)对模型聚合发起攻击,实验结果表明,恶意客户端能够通过产生相似的本地模型更新来窃取用户数据隐私.Gei等[19]证明了从梯度信息重建输入数据的可行性与深度网络架构无关,并将一批输入图像用余弦相似度和对抗攻击的方法恢复出来. ...

Inverting gradients how easy is it to break privacy in federated learning

2

2020

... 研究表明,梯度信息会泄露用户的隐私数据[14,15,16,17,18,19,20],攻击者可以通过客户端上传的梯度信息间接推出标签信息和数据集的成员信息.Carlini等[15]从训练用户语言数据的递归神经网络中提取出了用户的敏感数据,如特定的银行卡号.Fredrikson等[16]研究了如何从模型信息中窃取数据隐私,并通过药量预测实验实现了对线性回归模型的反演攻击,获得了患者的敏感信息.Hitaj等[18]用生成对抗网络(GAN)对模型聚合发起攻击,实验结果表明,恶意客户端能够通过产生相似的本地模型更新来窃取用户数据隐私.Gei等[19]证明了从梯度信息重建输入数据的可行性与深度网络架构无关,并将一批输入图像用余弦相似度和对抗攻击的方法恢复出来. ...

... [19]证明了从梯度信息重建输入数据的可行性与深度网络架构无关,并将一批输入图像用余弦相似度和对抗攻击的方法恢复出来. ...

Analyzing user-level privacy attack against federated learning

2

2020

... 研究表明,梯度信息会泄露用户的隐私数据[14,15,16,17,18,19,20],攻击者可以通过客户端上传的梯度信息间接推出标签信息和数据集的成员信息.Carlini等[15]从训练用户语言数据的递归神经网络中提取出了用户的敏感数据,如特定的银行卡号.Fredrikson等[16]研究了如何从模型信息中窃取数据隐私,并通过药量预测实验实现了对线性回归模型的反演攻击,获得了患者的敏感信息.Hitaj等[18]用生成对抗网络(GAN)对模型聚合发起攻击,实验结果表明,恶意客户端能够通过产生相似的本地模型更新来窃取用户数据隐私.Gei等[19]证明了从梯度信息重建输入数据的可行性与深度网络架构无关,并将一批输入图像用余弦相似度和对抗攻击的方法恢复出来. ...

... 如图5所示,联邦学习主要存在3种威胁:恶意客户端修改模型更新,破坏全局模型聚合;恶意分析者通过对模型更新信息的分析推测源数据隐私信息;恶意服务器企图获得客户端的源数据.针对以上威胁,增强联邦学习隐私安全性的主流方案与经典机器学习隐私保护技术结合,包括差分隐私(DP,differential privacy)、安全多方计算(MPC,secure multi-party computation)、同态加密(HE,homomorphic encryption)等技术[20].大量的研究表明,联邦学习与这些隐私保护技术的结合能够提供足够强的安全性,但仍然存在一些问题需要解决.例如,与差分隐私的结合在较少客户端参与的联邦学习中,模型精度受到较大的影响,虽然在大量客户端参与时能够通过模型加权平均抵消噪声误差,但算法中包含的大量超参数仍然限制了进一步的应用[21-22];与安全多方计算和同态加密技术的结合能够提供无损全局模型的构建,但同时会造成较大的通信开销[21-23],如何平衡通信负担和模型安全是一个相当大的挑战. ...

Differentially private federated learning:a client level perspective

3

2017

... 如图5所示,联邦学习主要存在3种威胁:恶意客户端修改模型更新,破坏全局模型聚合;恶意分析者通过对模型更新信息的分析推测源数据隐私信息;恶意服务器企图获得客户端的源数据.针对以上威胁,增强联邦学习隐私安全性的主流方案与经典机器学习隐私保护技术结合,包括差分隐私(DP,differential privacy)、安全多方计算(MPC,secure multi-party computation)、同态加密(HE,homomorphic encryption)等技术[20].大量的研究表明,联邦学习与这些隐私保护技术的结合能够提供足够强的安全性,但仍然存在一些问题需要解决.例如,与差分隐私的结合在较少客户端参与的联邦学习中,模型精度受到较大的影响,虽然在大量客户端参与时能够通过模型加权平均抵消噪声误差,但算法中包含的大量超参数仍然限制了进一步的应用[21-22];与安全多方计算和同态加密技术的结合能够提供无损全局模型的构建,但同时会造成较大的通信开销[21-23],如何平衡通信负担和模型安全是一个相当大的挑战. ...

... [21-23],如何平衡通信负担和模型安全是一个相当大的挑战. ...

... 在联邦学习进程中,恶意客户端能够通过对分布式模型的分析,获得客户端在训练过程中的贡献及数据集信息.Geyer等[21]提出一种针对客户端的差分隐私保护联邦优化算法,实现了对模型训练期间客户端贡献的隐藏,在有足够多客户端参与的情况下,能够以较小的模型性能成本来达到用户级差分隐私.McMahan等[22]同样使用差分隐私加密全局模型更新,证明了如果参与联邦学习的客户端数量足够多,对模型更新信息的加密就会以增加计算量为代价而不会降低模型精度.Bhowmick等[14]利用差分隐私技术,通过限制潜在对手的能力,提供同等隐私保护程度的同时保证了更好的模型性能. ...

Learning differentially private recurrent language models

2

2017

... 如图5所示,联邦学习主要存在3种威胁:恶意客户端修改模型更新,破坏全局模型聚合;恶意分析者通过对模型更新信息的分析推测源数据隐私信息;恶意服务器企图获得客户端的源数据.针对以上威胁,增强联邦学习隐私安全性的主流方案与经典机器学习隐私保护技术结合,包括差分隐私(DP,differential privacy)、安全多方计算(MPC,secure multi-party computation)、同态加密(HE,homomorphic encryption)等技术[20].大量的研究表明,联邦学习与这些隐私保护技术的结合能够提供足够强的安全性,但仍然存在一些问题需要解决.例如,与差分隐私的结合在较少客户端参与的联邦学习中,模型精度受到较大的影响,虽然在大量客户端参与时能够通过模型加权平均抵消噪声误差,但算法中包含的大量超参数仍然限制了进一步的应用[21-22];与安全多方计算和同态加密技术的结合能够提供无损全局模型的构建,但同时会造成较大的通信开销[21-23],如何平衡通信负担和模型安全是一个相当大的挑战. ...

... 在联邦学习进程中,恶意客户端能够通过对分布式模型的分析,获得客户端在训练过程中的贡献及数据集信息.Geyer等[21]提出一种针对客户端的差分隐私保护联邦优化算法,实现了对模型训练期间客户端贡献的隐藏,在有足够多客户端参与的情况下,能够以较小的模型性能成本来达到用户级差分隐私.McMahan等[22]同样使用差分隐私加密全局模型更新,证明了如果参与联邦学习的客户端数量足够多,对模型更新信息的加密就会以增加计算量为代价而不会降低模型精度.Bhowmick等[14]利用差分隐私技术,通过限制潜在对手的能力,提供同等隐私保护程度的同时保证了更好的模型性能. ...

Practical secure aggregation for privacy-preserving machine learning

2

2017

... 如图5所示,联邦学习主要存在3种威胁:恶意客户端修改模型更新,破坏全局模型聚合;恶意分析者通过对模型更新信息的分析推测源数据隐私信息;恶意服务器企图获得客户端的源数据.针对以上威胁,增强联邦学习隐私安全性的主流方案与经典机器学习隐私保护技术结合,包括差分隐私(DP,differential privacy)、安全多方计算(MPC,secure multi-party computation)、同态加密(HE,homomorphic encryption)等技术[20].大量的研究表明,联邦学习与这些隐私保护技术的结合能够提供足够强的安全性,但仍然存在一些问题需要解决.例如,与差分隐私的结合在较少客户端参与的联邦学习中,模型精度受到较大的影响,虽然在大量客户端参与时能够通过模型加权平均抵消噪声误差,但算法中包含的大量超参数仍然限制了进一步的应用[21-22];与安全多方计算和同态加密技术的结合能够提供无损全局模型的构建,但同时会造成较大的通信开销[21-23],如何平衡通信负担和模型安全是一个相当大的挑战. ...

... 针对不可信服务器和恶意敌手反演攻击的问题,结合传统的安全多方计算和同态加密等技术,能实现模型信息的无损加解密,但却大大增加了通信成本与计算开销.Bonawitz等[23]提出Secure Aggregation模型,结合秘密分享等技术使服务器无法解密单一客户端的梯度信息,仅能执行聚合操作得到全局模型,从而实现对恶意服务器的信息隐藏.Mandal等[24]在此工作基础上做了通信效率的改进,引入它非交互式成对密钥交互计算(NIKE)技术,在离线阶段计算主密钥的同时限定用户最多与L个邻居进行掩码操作,从而有效减少了秘密分享的时间开销.Dong 等[28]将秘密分享与同态加密应用于通信效率算法(TernGrad),解决了隐私泄露的同时大幅提升了框架的通信和计算开销.Hao等[52]通过改进BGV同态加密算法,消除了密钥交换操作并增加了纯文本空间,提供后量子安全性的同时避免了交互密钥导致的通信负担.在纵向联邦学习场景中,各部门进行训练数据对齐时可能造成标签信息和私有数据的泄露.Cheng等[25]通过改进XGBoost树模型提出SecureBoost算法,其利用RSA和哈希函数实现各方数据的共有样本ID对齐,同时使用加法同态加密保护各方交互的标签信息和梯度直方图信息,最终实现了与不添加隐私保护的联邦学习相同的模型精度.Aono 等[53]对深度神经网络模型进行同态加密的思想为联邦学习提供了新方向. ...

NIKE-based fast privacy-preserving high-dimensional data aggregation for mobile devices

1

2018

... 针对不可信服务器和恶意敌手反演攻击的问题,结合传统的安全多方计算和同态加密等技术,能实现模型信息的无损加解密,但却大大增加了通信成本与计算开销.Bonawitz等[23]提出Secure Aggregation模型,结合秘密分享等技术使服务器无法解密单一客户端的梯度信息,仅能执行聚合操作得到全局模型,从而实现对恶意服务器的信息隐藏.Mandal等[24]在此工作基础上做了通信效率的改进,引入它非交互式成对密钥交互计算(NIKE)技术,在离线阶段计算主密钥的同时限定用户最多与L个邻居进行掩码操作,从而有效减少了秘密分享的时间开销.Dong 等[28]将秘密分享与同态加密应用于通信效率算法(TernGrad),解决了隐私泄露的同时大幅提升了框架的通信和计算开销.Hao等[52]通过改进BGV同态加密算法,消除了密钥交换操作并增加了纯文本空间,提供后量子安全性的同时避免了交互密钥导致的通信负担.在纵向联邦学习场景中,各部门进行训练数据对齐时可能造成标签信息和私有数据的泄露.Cheng等[25]通过改进XGBoost树模型提出SecureBoost算法,其利用RSA和哈希函数实现各方数据的共有样本ID对齐,同时使用加法同态加密保护各方交互的标签信息和梯度直方图信息,最终实现了与不添加隐私保护的联邦学习相同的模型精度.Aono 等[53]对深度神经网络模型进行同态加密的思想为联邦学习提供了新方向. ...

Secureboost:a lossless federated learning framework

1

2019

... 针对不可信服务器和恶意敌手反演攻击的问题,结合传统的安全多方计算和同态加密等技术,能实现模型信息的无损加解密,但却大大增加了通信成本与计算开销.Bonawitz等[23]提出Secure Aggregation模型,结合秘密分享等技术使服务器无法解密单一客户端的梯度信息,仅能执行聚合操作得到全局模型,从而实现对恶意服务器的信息隐藏.Mandal等[24]在此工作基础上做了通信效率的改进,引入它非交互式成对密钥交互计算(NIKE)技术,在离线阶段计算主密钥的同时限定用户最多与L个邻居进行掩码操作,从而有效减少了秘密分享的时间开销.Dong 等[28]将秘密分享与同态加密应用于通信效率算法(TernGrad),解决了隐私泄露的同时大幅提升了框架的通信和计算开销.Hao等[52]通过改进BGV同态加密算法,消除了密钥交换操作并增加了纯文本空间,提供后量子安全性的同时避免了交互密钥导致的通信负担.在纵向联邦学习场景中,各部门进行训练数据对齐时可能造成标签信息和私有数据的泄露.Cheng等[25]通过改进XGBoost树模型提出SecureBoost算法,其利用RSA和哈希函数实现各方数据的共有样本ID对齐,同时使用加法同态加密保护各方交互的标签信息和梯度直方图信息,最终实现了与不添加隐私保护的联邦学习相同的模型精度.Aono 等[53]对深度神经网络模型进行同态加密的思想为联邦学习提供了新方向. ...

区块链技术发展现状与展望

1

2016

... 针对以上问题,学术界通过结合区块链技术做出了大量研究.区块链是比特币的底层技术,它作为一种安全可靠、不可篡改和支持查询验证的分布式分类账,被应用于解决各类数据安全存储和信任问题[26-27].联邦学习通过集成区块链能够以一种安全、高度抗中断和可审计的方式记录其模型更新,为系统框架提供可问责性和不可否认性.同时,区块链的激励机制作为一种经济回报能够根据构建模型时客户端的贡献给予相应的奖励. ...

区块链技术发展现状与展望

1

2016

... 针对以上问题,学术界通过结合区块链技术做出了大量研究.区块链是比特币的底层技术,它作为一种安全可靠、不可篡改和支持查询验证的分布式分类账,被应用于解决各类数据安全存储和信任问题[26-27].联邦学习通过集成区块链能够以一种安全、高度抗中断和可审计的方式记录其模型更新,为系统框架提供可问责性和不可否认性.同时,区块链的激励机制作为一种经济回报能够根据构建模型时客户端的贡献给予相应的奖励. ...

Integrated blockchain and edge computing systems:a survey,some research issues and challenges

1

2019

... 针对以上问题,学术界通过结合区块链技术做出了大量研究.区块链是比特币的底层技术,它作为一种安全可靠、不可篡改和支持查询验证的分布式分类账,被应用于解决各类数据安全存储和信任问题[26-27].联邦学习通过集成区块链能够以一种安全、高度抗中断和可审计的方式记录其模型更新,为系统框架提供可问责性和不可否认性.同时,区块链的激励机制作为一种经济回报能够根据构建模型时客户端的贡献给予相应的奖励. ...

EaSTFLy:efficient and secure ternary federated learning

2

2020

... 在大多数情况下,这几种方法是相辅相成的,通过特定的方法把这几种方案结合是研究的热点方向[28-29].表1给出现有通信效率算法的性能比较. ...

... 针对不可信服务器和恶意敌手反演攻击的问题,结合传统的安全多方计算和同态加密等技术,能实现模型信息的无损加解密,但却大大增加了通信成本与计算开销.Bonawitz等[23]提出Secure Aggregation模型,结合秘密分享等技术使服务器无法解密单一客户端的梯度信息,仅能执行聚合操作得到全局模型,从而实现对恶意服务器的信息隐藏.Mandal等[24]在此工作基础上做了通信效率的改进,引入它非交互式成对密钥交互计算(NIKE)技术,在离线阶段计算主密钥的同时限定用户最多与L个邻居进行掩码操作,从而有效减少了秘密分享的时间开销.Dong 等[28]将秘密分享与同态加密应用于通信效率算法(TernGrad),解决了隐私泄露的同时大幅提升了框架的通信和计算开销.Hao等[52]通过改进BGV同态加密算法,消除了密钥交换操作并增加了纯文本空间,提供后量子安全性的同时避免了交互密钥导致的通信负担.在纵向联邦学习场景中,各部门进行训练数据对齐时可能造成标签信息和私有数据的泄露.Cheng等[25]通过改进XGBoost树模型提出SecureBoost算法,其利用RSA和哈希函数实现各方数据的共有样本ID对齐,同时使用加法同态加密保护各方交互的标签信息和梯度直方图信息,最终实现了与不添加隐私保护的联邦学习相同的模型精度.Aono 等[53]对深度神经网络模型进行同态加密的思想为联邦学习提供了新方向. ...

IFed:a novel federated learning framework for local differential privacy in power internet of things

2

2020

... 在大多数情况下,这几种方法是相辅相成的,通过特定的方法把这几种方案结合是研究的热点方向[28-29].表1给出现有通信效率算法的性能比较. ...

... 另一个研究热点是联邦学习与差分隐私的融合,由于差分隐私不增加客户端通信成本,被广泛应用于模型更新的隐私保护.学术界的研究主要致力于在保护隐私信息的前提下,尽可能地减少噪声对模型训练的影响,进而提升模型性能.Liu等[54]提出一种自适应隐私保护的APFL方案,通过分析数据集的特征向量对输出模型的影响,为不同贡献的特征向量分配不同的隐私预算ε,同时减少贡献较少的数据集的噪声,实现严格差分隐私的同时高效保证了全局模型精度与性能.Huang 等[55]针对客户端之间的不平衡数据提出DP-FL框架,其根据每个用户的数据量设置不同的差分隐私预算ε,设计具有自适应梯度下降算法的差分隐私专用卷积神经网络,来更新每个用户的训练参数,结果证明相较于传统的FL框架,该方案在不平衡数据集中表现较好.Wei等[56]将差分隐私与FL的结合做了深入的分析,证明存在最优的K值(1≤K≤总客户端数N),可以在固定的隐私保护级别上实现最佳的收敛性能.Cao 等[29]则从通信效率和隐私保护的结合出发,结合本地差分隐私,为物联网终端低算力设备提供了资源消耗的隐私保护框架. ...

Revisiting distributed synchronous SGD

1

2016

... 在分布式计算框架中,客户端每运行一次SGD算法训练,机器学习模型就会向中心服务器上传本轮产生的本地模型更新.但是,频繁的通信交互会对参与训练各方造成不必要的通信负担.McMahan等[2]针对联邦学习的低带宽环境提出FedAvg算法,要求客户端在本地多次执行SGD算法,然后与中心服务器交互模型更新,实现用更少的通信轮数训练出相同精度的模型.相比于基准算法 FedSGD[30],其在训练不同神经网络的通信轮数上减少了 1%~10%,但该算法对于非凸问题没有收敛保证,在非 IID 数据集上难以收敛[31]. ...

Robust and communication-efficient federated learning from Non-IID data

2

2019

... 在分布式计算框架中,客户端每运行一次SGD算法训练,机器学习模型就会向中心服务器上传本轮产生的本地模型更新.但是,频繁的通信交互会对参与训练各方造成不必要的通信负担.McMahan等[2]针对联邦学习的低带宽环境提出FedAvg算法,要求客户端在本地多次执行SGD算法,然后与中心服务器交互模型更新,实现用更少的通信轮数训练出相同精度的模型.相比于基准算法 FedSGD[30],其在训练不同神经网络的通信轮数上减少了 1%~10%,但该算法对于非凸问题没有收敛保证,在非 IID 数据集上难以收敛[31]. ...

... 另外,现有的大部分压缩方法只在呈IID分布的客户端数据下表现良好,这些方法并不适合联邦学习场景.对此,Sattler等[31]提出一种新的稀疏三元压缩(STC)框架,STC 扩展了现有的top-k梯度稀疏化压缩技术,通过Golomb无损编码压缩联邦框架交互的模型更新,使算法更适用于高频率低容量的联邦学习环境,同时保证了在大量客户端参与下的鲁棒性. ...

Averaging is probably not the optimum way of aggregating parameters in federated learning

2

2020

... 自 FedAvg 算法被提出,后续大量研究在此基础上做进一步的拓展,但 FedAvg 算法本身有一定的缺陷[32].首先,服务器端聚合时根据客户端数据量大小来分配相应的权重,这导致拥有大量重复数据的客户端能够轻易影响全局模型;其次,客户端仅执行 SGD 算法和执行固定次数的SGD算法一定限度上限制了模型训练的速度.对此,Li等[33]提出FedProx算法,根据客户端设备可用的系统资源执行可变次数的SGD算法,缩短收敛时间的同时将模型更新数据压缩了1/2~1/3,更加适用于客户端数据质量、计算资源等联邦学习场景.同样是针对联邦学习框架的改进,Liu等[34]认为传统的FL仅利用一阶梯度下降(GD),忽略了对梯度更新的先前迭代,提出了MFL方案,在联邦学习的本地模型更新阶段使用动量梯度下降(MGD),实验证明,在一定条件下该方案显著提升了模型训练的收敛速度.Huang等[35]提出迭代自适应的LoAdaBoost算法,通过分析客户端更新的交叉熵损失,调整本地客户端 epoch 次数,相对于传统 FedAvg 算法固定epoch,准确度与收敛速度均有显著提升. ...

... 在联邦学习中,通信拓扑通常是星形拓扑,但这往往会造成中心服务器的通信成本太大,分散拓扑(客户端只与它们的邻居通信)可以作为一种替代方案,如图6 所示.在低带宽或高时延网络上运行时,分散拓扑被证明比星形拓扑训练速度更快[32,33,34,35,36,37,38,39,40].联邦学习的分散拓扑[41,42,43,44]先设定边缘服务器聚合来自客户端设备的本地更新,然后边缘服务器充当客户端的角色与中心服务器交互.例如,Sharma等[43]构建了一个多层分布式计算防御框架,通过数据层、边缘层、雾层和云层的协同决策,解决海量数据集中传输的问题.通过这种分层通信的方法可以有效降低中央服务器的通信负担,但它并不适用于所有的场景,因为这种物理层次可能不存在,也不可能预先知道. ...

Federated optimization in heterogeneous networks

2

2018

... 自 FedAvg 算法被提出,后续大量研究在此基础上做进一步的拓展,但 FedAvg 算法本身有一定的缺陷[32].首先,服务器端聚合时根据客户端数据量大小来分配相应的权重,这导致拥有大量重复数据的客户端能够轻易影响全局模型;其次,客户端仅执行 SGD 算法和执行固定次数的SGD算法一定限度上限制了模型训练的速度.对此,Li等[33]提出FedProx算法,根据客户端设备可用的系统资源执行可变次数的SGD算法,缩短收敛时间的同时将模型更新数据压缩了1/2~1/3,更加适用于客户端数据质量、计算资源等联邦学习场景.同样是针对联邦学习框架的改进,Liu等[34]认为传统的FL仅利用一阶梯度下降(GD),忽略了对梯度更新的先前迭代,提出了MFL方案,在联邦学习的本地模型更新阶段使用动量梯度下降(MGD),实验证明,在一定条件下该方案显著提升了模型训练的收敛速度.Huang等[35]提出迭代自适应的LoAdaBoost算法,通过分析客户端更新的交叉熵损失,调整本地客户端 epoch 次数,相对于传统 FedAvg 算法固定epoch,准确度与收敛速度均有显著提升. ...

... 在联邦学习中,通信拓扑通常是星形拓扑,但这往往会造成中心服务器的通信成本太大,分散拓扑(客户端只与它们的邻居通信)可以作为一种替代方案,如图6 所示.在低带宽或高时延网络上运行时,分散拓扑被证明比星形拓扑训练速度更快[32,33,34,35,36,37,38,39,40].联邦学习的分散拓扑[41,42,43,44]先设定边缘服务器聚合来自客户端设备的本地更新,然后边缘服务器充当客户端的角色与中心服务器交互.例如,Sharma等[43]构建了一个多层分布式计算防御框架,通过数据层、边缘层、雾层和云层的协同决策,解决海量数据集中传输的问题.通过这种分层通信的方法可以有效降低中央服务器的通信负担,但它并不适用于所有的场景,因为这种物理层次可能不存在,也不可能预先知道. ...

Accelerating federated learning via momentum gradient descent

2

2020

... 自 FedAvg 算法被提出,后续大量研究在此基础上做进一步的拓展,但 FedAvg 算法本身有一定的缺陷[32].首先,服务器端聚合时根据客户端数据量大小来分配相应的权重,这导致拥有大量重复数据的客户端能够轻易影响全局模型;其次,客户端仅执行 SGD 算法和执行固定次数的SGD算法一定限度上限制了模型训练的速度.对此,Li等[33]提出FedProx算法,根据客户端设备可用的系统资源执行可变次数的SGD算法,缩短收敛时间的同时将模型更新数据压缩了1/2~1/3,更加适用于客户端数据质量、计算资源等联邦学习场景.同样是针对联邦学习框架的改进,Liu等[34]认为传统的FL仅利用一阶梯度下降(GD),忽略了对梯度更新的先前迭代,提出了MFL方案,在联邦学习的本地模型更新阶段使用动量梯度下降(MGD),实验证明,在一定条件下该方案显著提升了模型训练的收敛速度.Huang等[35]提出迭代自适应的LoAdaBoost算法,通过分析客户端更新的交叉熵损失,调整本地客户端 epoch 次数,相对于传统 FedAvg 算法固定epoch,准确度与收敛速度均有显著提升. ...

... 在联邦学习中,通信拓扑通常是星形拓扑,但这往往会造成中心服务器的通信成本太大,分散拓扑(客户端只与它们的邻居通信)可以作为一种替代方案,如图6 所示.在低带宽或高时延网络上运行时,分散拓扑被证明比星形拓扑训练速度更快[32,33,34,35,36,37,38,39,40].联邦学习的分散拓扑[41,42,43,44]先设定边缘服务器聚合来自客户端设备的本地更新,然后边缘服务器充当客户端的角色与中心服务器交互.例如,Sharma等[43]构建了一个多层分布式计算防御框架,通过数据层、边缘层、雾层和云层的协同决策,解决海量数据集中传输的问题.通过这种分层通信的方法可以有效降低中央服务器的通信负担,但它并不适用于所有的场景,因为这种物理层次可能不存在,也不可能预先知道. ...

LoAdaBoost:loss-based AdaBoost federated machine learning with reduced computational complexity on IID and non-IID intensive care data

2

2020

... 自 FedAvg 算法被提出,后续大量研究在此基础上做进一步的拓展,但 FedAvg 算法本身有一定的缺陷[32].首先,服务器端聚合时根据客户端数据量大小来分配相应的权重,这导致拥有大量重复数据的客户端能够轻易影响全局模型;其次,客户端仅执行 SGD 算法和执行固定次数的SGD算法一定限度上限制了模型训练的速度.对此,Li等[33]提出FedProx算法,根据客户端设备可用的系统资源执行可变次数的SGD算法,缩短收敛时间的同时将模型更新数据压缩了1/2~1/3,更加适用于客户端数据质量、计算资源等联邦学习场景.同样是针对联邦学习框架的改进,Liu等[34]认为传统的FL仅利用一阶梯度下降(GD),忽略了对梯度更新的先前迭代,提出了MFL方案,在联邦学习的本地模型更新阶段使用动量梯度下降(MGD),实验证明,在一定条件下该方案显著提升了模型训练的收敛速度.Huang等[35]提出迭代自适应的LoAdaBoost算法,通过分析客户端更新的交叉熵损失,调整本地客户端 epoch 次数,相对于传统 FedAvg 算法固定epoch,准确度与收敛速度均有显著提升. ...

... 在联邦学习中,通信拓扑通常是星形拓扑,但这往往会造成中心服务器的通信成本太大,分散拓扑(客户端只与它们的邻居通信)可以作为一种替代方案,如图6 所示.在低带宽或高时延网络上运行时,分散拓扑被证明比星形拓扑训练速度更快[32,33,34,35,36,37,38,39,40].联邦学习的分散拓扑[41,42,43,44]先设定边缘服务器聚合来自客户端设备的本地更新,然后边缘服务器充当客户端的角色与中心服务器交互.例如,Sharma等[43]构建了一个多层分布式计算防御框架,通过数据层、边缘层、雾层和云层的协同决策,解决海量数据集中传输的问题.通过这种分层通信的方法可以有效降低中央服务器的通信负担,但它并不适用于所有的场景,因为这种物理层次可能不存在,也不可能预先知道. ...

BACombo—bandwidth-aware decentralized federated learning

2

2020

... 除了对最初的FedAvg算法的各种改进以外,在客户端或者服务器上增加筛选算法也是研究方向之一.Wang等[12]认为客户端上传的本地模型更新中含有大量的冗余和不相关信息,严重占用通信带宽,因此提出CMFL算法,该算法要求客户端筛选本地模型更新与上一轮全局模型的相关度,通过模型梯度正负符号相同的百分比来避免上传达不到阈值要求的本地模型更新,实现通信开销的降低,但该算法建立在客户端按照协议执行的基础上,系统的鲁棒性较弱.Jiang等[36]提出了 BACombo 算法,利用 gossip 协议和 epsilongreedy 算法检查客户端之间随时间变化的平均带宽,最大限度地利用带宽容量,进而加快收敛速度. ...

... 在联邦学习中,通信拓扑通常是星形拓扑,但这往往会造成中心服务器的通信成本太大,分散拓扑(客户端只与它们的邻居通信)可以作为一种替代方案,如图6 所示.在低带宽或高时延网络上运行时,分散拓扑被证明比星形拓扑训练速度更快[32,33,34,35,36,37,38,39,40].联邦学习的分散拓扑[41,42,43,44]先设定边缘服务器聚合来自客户端设备的本地更新,然后边缘服务器充当客户端的角色与中心服务器交互.例如,Sharma等[43]构建了一个多层分布式计算防御框架,通过数据层、边缘层、雾层和云层的协同决策,解决海量数据集中传输的问题.通过这种分层通信的方法可以有效降低中央服务器的通信负担,但它并不适用于所有的场景,因为这种物理层次可能不存在,也不可能预先知道. ...

Fedpaq:a communication-efficient federated learning method with periodic averaging and quantization

2

2020

... 横向联邦学习中往往有大量的本地客户端,很难保证每个客户端都拥有稳定可靠的网络连接,低质量的通信会严重降低通信速度.Konečný等[11]提出针对本地模型的结构化更新和草图更新算法,客户端被要求在一个低秩或随机掩码后的有限空间中进行模型学习,然后草图更新算法对模型更新进行量化、随机旋转和子采样等压缩操作,该方案被证明在SGD迭代方面显著减慢了收敛速度.在上述基础上,Caldas等[13]将该方法应用于对全局模型更新的压缩中,同时提出Federated Dropout思想优化模型更新,中心服务器随机选择全局模型的更小子集并采用量化、随机旋转和子采样等压缩操作,客户端接收到全局模型后解压缩并进行本地模型训练,从而减少了联邦学习对客户端设备资源的影响,允许培训更高容量的模型,并接触到更多样化的用户.Reisizadeh 等[37]选择将算法优化与压缩的思路结合起来,其提出的FedPAQ算法要求服务器只选择一小部分客户端参与训练,同时客户端减少上传本地模型次数并在上传之前进行量化更新操作减小通信量. ...

... 在联邦学习中,通信拓扑通常是星形拓扑,但这往往会造成中心服务器的通信成本太大,分散拓扑(客户端只与它们的邻居通信)可以作为一种替代方案,如图6 所示.在低带宽或高时延网络上运行时,分散拓扑被证明比星形拓扑训练速度更快[32,33,34,35,36,37,38,39,40].联邦学习的分散拓扑[41,42,43,44]先设定边缘服务器聚合来自客户端设备的本地更新,然后边缘服务器充当客户端的角色与中心服务器交互.例如,Sharma等[43]构建了一个多层分布式计算防御框架,通过数据层、边缘层、雾层和云层的协同决策,解决海量数据集中传输的问题.通过这种分层通信的方法可以有效降低中央服务器的通信负担,但它并不适用于所有的场景,因为这种物理层次可能不存在,也不可能预先知道. ...

Privacy-preserving asynchronous federated learning mechanism for edge network computing

2

2020

... 但是,上述算法采取的都是固定阈值的压缩通信,这种方式在客户端之间模型更新差异较大时显得并不合理.对此,Lu等[38]提出自适应阈值梯度压缩算法,客户端通过判断梯度变化,计算得到适当的阈值用于压缩通信,同时保证模型的性能损失较小. ...

... 在联邦学习中,通信拓扑通常是星形拓扑,但这往往会造成中心服务器的通信成本太大,分散拓扑(客户端只与它们的邻居通信)可以作为一种替代方案,如图6 所示.在低带宽或高时延网络上运行时,分散拓扑被证明比星形拓扑训练速度更快[32,33,34,35,36,37,38,39,40].联邦学习的分散拓扑[41,42,43,44]先设定边缘服务器聚合来自客户端设备的本地更新,然后边缘服务器充当客户端的角色与中心服务器交互.例如,Sharma等[43]构建了一个多层分布式计算防御框架,通过数据层、边缘层、雾层和云层的协同决策,解决海量数据集中传输的问题.通过这种分层通信的方法可以有效降低中央服务器的通信负担,但它并不适用于所有的场景,因为这种物理层次可能不存在,也不可能预先知道. ...

Cola:decentralized linear learning

1

2018

... 在联邦学习中,通信拓扑通常是星形拓扑,但这往往会造成中心服务器的通信成本太大,分散拓扑(客户端只与它们的邻居通信)可以作为一种替代方案,如图6 所示.在低带宽或高时延网络上运行时,分散拓扑被证明比星形拓扑训练速度更快[32,33,34,35,36,37,38,39,40].联邦学习的分散拓扑[41,42,43,44]先设定边缘服务器聚合来自客户端设备的本地更新,然后边缘服务器充当客户端的角色与中心服务器交互.例如,Sharma等[43]构建了一个多层分布式计算防御框架,通过数据层、边缘层、雾层和云层的协同决策,解决海量数据集中传输的问题.通过这种分层通信的方法可以有效降低中央服务器的通信负担,但它并不适用于所有的场景,因为这种物理层次可能不存在,也不可能预先知道. ...

Decentralized Bayesian learning over graphs

1

2019

... 在联邦学习中,通信拓扑通常是星形拓扑,但这往往会造成中心服务器的通信成本太大,分散拓扑(客户端只与它们的邻居通信)可以作为一种替代方案,如图6 所示.在低带宽或高时延网络上运行时,分散拓扑被证明比星形拓扑训练速度更快[32,33,34,35,36,37,38,39,40].联邦学习的分散拓扑[41,42,43,44]先设定边缘服务器聚合来自客户端设备的本地更新,然后边缘服务器充当客户端的角色与中心服务器交互.例如,Sharma等[43]构建了一个多层分布式计算防御框架,通过数据层、边缘层、雾层和云层的协同决策,解决海量数据集中传输的问题.通过这种分层通信的方法可以有效降低中央服务器的通信负担,但它并不适用于所有的场景,因为这种物理层次可能不存在,也不可能预先知道. ...

Don't use large mini-batches,use local SGD

1

2018

... 在联邦学习中,通信拓扑通常是星形拓扑,但这往往会造成中心服务器的通信成本太大,分散拓扑(客户端只与它们的邻居通信)可以作为一种替代方案,如图6 所示.在低带宽或高时延网络上运行时,分散拓扑被证明比星形拓扑训练速度更快[32,33,34,35,36,37,38,39,40].联邦学习的分散拓扑[41,42,43,44]先设定边缘服务器聚合来自客户端设备的本地更新,然后边缘服务器充当客户端的角色与中心服务器交互.例如,Sharma等[43]构建了一个多层分布式计算防御框架,通过数据层、边缘层、雾层和云层的协同决策,解决海量数据集中传输的问题.通过这种分层通信的方法可以有效降低中央服务器的通信负担,但它并不适用于所有的场景,因为这种物理层次可能不存在,也不可能预先知道. ...

Edge-assisted hierarchical federated learning with non-iid data

1

2019

... 在联邦学习中,通信拓扑通常是星形拓扑,但这往往会造成中心服务器的通信成本太大,分散拓扑(客户端只与它们的邻居通信)可以作为一种替代方案,如图6 所示.在低带宽或高时延网络上运行时,分散拓扑被证明比星形拓扑训练速度更快[32,33,34,35,36,37,38,39,40].联邦学习的分散拓扑[41,42,43,44]先设定边缘服务器聚合来自客户端设备的本地更新,然后边缘服务器充当客户端的角色与中心服务器交互.例如,Sharma等[43]构建了一个多层分布式计算防御框架,通过数据层、边缘层、雾层和云层的协同决策,解决海量数据集中传输的问题.通过这种分层通信的方法可以有效降低中央服务器的通信负担,但它并不适用于所有的场景,因为这种物理层次可能不存在,也不可能预先知道. ...

Blockchain and federated learning-based distributed computing defence framework for sustainable society

3

2020

... 在联邦学习中,通信拓扑通常是星形拓扑,但这往往会造成中心服务器的通信成本太大,分散拓扑(客户端只与它们的邻居通信)可以作为一种替代方案,如图6 所示.在低带宽或高时延网络上运行时,分散拓扑被证明比星形拓扑训练速度更快[32,33,34,35,36,37,38,39,40].联邦学习的分散拓扑[41,42,43,44]先设定边缘服务器聚合来自客户端设备的本地更新,然后边缘服务器充当客户端的角色与中心服务器交互.例如,Sharma等[43]构建了一个多层分布式计算防御框架,通过数据层、边缘层、雾层和云层的协同决策,解决海量数据集中传输的问题.通过这种分层通信的方法可以有效降低中央服务器的通信负担,但它并不适用于所有的场景,因为这种物理层次可能不存在,也不可能预先知道. ...

... [43]构建了一个多层分布式计算防御框架,通过数据层、边缘层、雾层和云层的协同决策,解决海量数据集中传输的问题.通过这种分层通信的方法可以有效降低中央服务器的通信负担,但它并不适用于所有的场景,因为这种物理层次可能不存在,也不可能预先知道. ...

... 联邦学习中,由于服务器的中心聚合作用,其设备一旦受到敌手单点攻击就会对整个学习框架造成很大的安全隐患.为提升框架的安全性、可信性、可靠性,Majeed等[67]提出基于区块链的FLchain 架构,以提升联邦学习的安全性,在FLchain 中,对于每个全局模型,框架都会创建一个新的通道来存储特定通道分类账,同时创建“全局模型状态树”来跟踪全局模型的权重更新, FLchain以一种不可篡改的方式保证了FL模型的起源性和可审计性.Sharma等[43]在分布式多层计算框架的基础上使用离线区块链和在线区块链实时存储大量节点的临时训练数据,利用多层和多链结构有效减少网络故障、恶意攻击对联邦学习的影响,但没有将区块链的激励机制作为提升模型性能的辅助措施.Arachchige 等[68]通过融合差分隐私、联邦学习、以太坊区块链和智能合约构建了名为PriModChain的框架,为联邦学习在工业物联网中的应用提供了隐私性、安全性与可靠性,但该框架的运行效率限制了其进一步的发展.Lu等[69]提出了一种新的混合区块链架构,其由许可区块链和本地有向无环图(DAG)组成,以实现车联网中的有效数据共享,提升学习模型的可靠性.Pokhrel等[70]通过私有区块链提出一种多级信任框架,以实现本地模型更新从观察到学习和验证的端到端可信性. ...

FedMEC:improving efficiency of differentially private federated learning via mobile edge computing

1

2020

... 在联邦学习中,通信拓扑通常是星形拓扑,但这往往会造成中心服务器的通信成本太大,分散拓扑(客户端只与它们的邻居通信)可以作为一种替代方案,如图6 所示.在低带宽或高时延网络上运行时,分散拓扑被证明比星形拓扑训练速度更快[32,33,34,35,36,37,38,39,40].联邦学习的分散拓扑[41,42,43,44]先设定边缘服务器聚合来自客户端设备的本地更新,然后边缘服务器充当客户端的角色与中心服务器交互.例如,Sharma等[43]构建了一个多层分布式计算防御框架,通过数据层、边缘层、雾层和云层的协同决策,解决海量数据集中传输的问题.通过这种分层通信的方法可以有效降低中央服务器的通信负担,但它并不适用于所有的场景,因为这种物理层次可能不存在,也不可能预先知道. ...

机器学习的隐私保护研究综述

1

2020

... 现有的方案主要通过结合典型隐私保护技术来提供进一步的隐私增强,如差分隐私、安全多方计算、同态加密等技术,这些技术在之前的研究中已经被广泛应用于传统机器学习的隐私保护[45]. ...

机器学习的隐私保护研究综述

1

2020

... 现有的方案主要通过结合典型隐私保护技术来提供进一步的隐私增强,如差分隐私、安全多方计算、同态加密等技术,这些技术在之前的研究中已经被广泛应用于传统机器学习的隐私保护[45]. ...

Calibrating noise to sensitivity in private data analysis

1

2006

... Dwork 等[46]于 2006 年提出差分隐私概念,并使用严格的数学推导给出了安全性证明.通常差分隐私算法的噪声机制分为指数噪声、Laplace噪声和高斯噪声,其中,指数噪声主要用于处理离散数据集,Laplace噪声和高斯噪声主要用于处理连续数据集. ...

安全多方计算技术与应用综述

1

2019

... 定义2 安全多方计算[48].假设有n个参与方P1, P2,…,Pn分别拥有自己的敏感数据m1,m 2,…,m n,这n个参与者在不泄露各自输入数据的前提下共同执行一个协议函数f(m1,m2,…,mn). ...

安全多方计算技术与应用综述

1

2019

... 定义2 安全多方计算[48].假设有n个参与方P1, P2,…,Pn分别拥有自己的敏感数据m1,m 2,…,m n,这n个参与者在不泄露各自输入数据的前提下共同执行一个协议函数f(m1,m2,…,mn). ...

On the security of public key protocols

1

1983

... 安全多方计算的研究焦点是在没有可信第三方的条件下,参与训练各方安全计算的一个共同的约束函数.姚期智[49]于 1983 年提出安全多方计算的概念,通过混淆电路、不经意传输、秘密分享等技术实现多方共同运算,并确保各方数据的安全性. ...

A method for obtaining digital signatures and public-key cryptosystems

1

1978

... 则称该加密算法满足同态加密.同态加密能够直接对密文数据进行密码学运算,最终运算结果经解密后与在明文上直接运算结果一致.Rivest等[50]于1978年提出同态加密概念.同态加密分为全同态加密和部分同态加密,其中部分同态加密分为乘法同态和加法同态,若一个算法既满足乘法同态又满足加法同态,则称为全同态加密算法. ...

Differentially private learning with adaptive clipping

1

2019

... 但是,上述方案中都存在许多影响通信效率和精度的超参数,用户必须谨慎选择才能达到预期效果.Thakkar 等[51]针对这个缺点提出自适应梯度裁剪策略,对特定层添加不同的噪声,同时对迭代差分隐私机制应用自适应分数剪裁,有效缓解了差分隐私算法中超参数过多的问题. ...

Efficient and privacy-enhanced federated learning for industrial artificial intelligence

1

2019

... 针对不可信服务器和恶意敌手反演攻击的问题,结合传统的安全多方计算和同态加密等技术,能实现模型信息的无损加解密,但却大大增加了通信成本与计算开销.Bonawitz等[23]提出Secure Aggregation模型,结合秘密分享等技术使服务器无法解密单一客户端的梯度信息,仅能执行聚合操作得到全局模型,从而实现对恶意服务器的信息隐藏.Mandal等[24]在此工作基础上做了通信效率的改进,引入它非交互式成对密钥交互计算(NIKE)技术,在离线阶段计算主密钥的同时限定用户最多与L个邻居进行掩码操作,从而有效减少了秘密分享的时间开销.Dong 等[28]将秘密分享与同态加密应用于通信效率算法(TernGrad),解决了隐私泄露的同时大幅提升了框架的通信和计算开销.Hao等[52]通过改进BGV同态加密算法,消除了密钥交换操作并增加了纯文本空间,提供后量子安全性的同时避免了交互密钥导致的通信负担.在纵向联邦学习场景中,各部门进行训练数据对齐时可能造成标签信息和私有数据的泄露.Cheng等[25]通过改进XGBoost树模型提出SecureBoost算法,其利用RSA和哈希函数实现各方数据的共有样本ID对齐,同时使用加法同态加密保护各方交互的标签信息和梯度直方图信息,最终实现了与不添加隐私保护的联邦学习相同的模型精度.Aono 等[53]对深度神经网络模型进行同态加密的思想为联邦学习提供了新方向. ...

Privacy-preserving deep learning via additively homomorphic encryption

1

2017

... 针对不可信服务器和恶意敌手反演攻击的问题,结合传统的安全多方计算和同态加密等技术,能实现模型信息的无损加解密,但却大大增加了通信成本与计算开销.Bonawitz等[23]提出Secure Aggregation模型,结合秘密分享等技术使服务器无法解密单一客户端的梯度信息,仅能执行聚合操作得到全局模型,从而实现对恶意服务器的信息隐藏.Mandal等[24]在此工作基础上做了通信效率的改进,引入它非交互式成对密钥交互计算(NIKE)技术,在离线阶段计算主密钥的同时限定用户最多与L个邻居进行掩码操作,从而有效减少了秘密分享的时间开销.Dong 等[28]将秘密分享与同态加密应用于通信效率算法(TernGrad),解决了隐私泄露的同时大幅提升了框架的通信和计算开销.Hao等[52]通过改进BGV同态加密算法,消除了密钥交换操作并增加了纯文本空间,提供后量子安全性的同时避免了交互密钥导致的通信负担.在纵向联邦学习场景中,各部门进行训练数据对齐时可能造成标签信息和私有数据的泄露.Cheng等[25]通过改进XGBoost树模型提出SecureBoost算法,其利用RSA和哈希函数实现各方数据的共有样本ID对齐,同时使用加法同态加密保护各方交互的标签信息和梯度直方图信息,最终实现了与不添加隐私保护的联邦学习相同的模型精度.Aono 等[53]对深度神经网络模型进行同态加密的思想为联邦学习提供了新方向. ...

Adaptive privacy-preserving federated learning

1

2020

... 另一个研究热点是联邦学习与差分隐私的融合,由于差分隐私不增加客户端通信成本,被广泛应用于模型更新的隐私保护.学术界的研究主要致力于在保护隐私信息的前提下,尽可能地减少噪声对模型训练的影响,进而提升模型性能.Liu等[54]提出一种自适应隐私保护的APFL方案,通过分析数据集的特征向量对输出模型的影响,为不同贡献的特征向量分配不同的隐私预算ε,同时减少贡献较少的数据集的噪声,实现严格差分隐私的同时高效保证了全局模型精度与性能.Huang 等[55]针对客户端之间的不平衡数据提出DP-FL框架,其根据每个用户的数据量设置不同的差分隐私预算ε,设计具有自适应梯度下降算法的差分隐私专用卷积神经网络,来更新每个用户的训练参数,结果证明相较于传统的FL框架,该方案在不平衡数据集中表现较好.Wei等[56]将差分隐私与FL的结合做了深入的分析,证明存在最优的K值(1≤K≤总客户端数N),可以在固定的隐私保护级别上实现最佳的收敛性能.Cao 等[29]则从通信效率和隐私保护的结合出发,结合本地差分隐私,为物联网终端低算力设备提供了资源消耗的隐私保护框架. ...

DP-FL:a novel differentially private federated learning framework for the unbalanced data

1

2020

... 另一个研究热点是联邦学习与差分隐私的融合,由于差分隐私不增加客户端通信成本,被广泛应用于模型更新的隐私保护.学术界的研究主要致力于在保护隐私信息的前提下,尽可能地减少噪声对模型训练的影响,进而提升模型性能.Liu等[54]提出一种自适应隐私保护的APFL方案,通过分析数据集的特征向量对输出模型的影响,为不同贡献的特征向量分配不同的隐私预算ε,同时减少贡献较少的数据集的噪声,实现严格差分隐私的同时高效保证了全局模型精度与性能.Huang 等[55]针对客户端之间的不平衡数据提出DP-FL框架,其根据每个用户的数据量设置不同的差分隐私预算ε,设计具有自适应梯度下降算法的差分隐私专用卷积神经网络,来更新每个用户的训练参数,结果证明相较于传统的FL框架,该方案在不平衡数据集中表现较好.Wei等[56]将差分隐私与FL的结合做了深入的分析,证明存在最优的K值(1≤K≤总客户端数N),可以在固定的隐私保护级别上实现最佳的收敛性能.Cao 等[29]则从通信效率和隐私保护的结合出发,结合本地差分隐私,为物联网终端低算力设备提供了资源消耗的隐私保护框架. ...

Federated learning with differential privacy:algorithms and performance analysis

1

2020

... 另一个研究热点是联邦学习与差分隐私的融合,由于差分隐私不增加客户端通信成本,被广泛应用于模型更新的隐私保护.学术界的研究主要致力于在保护隐私信息的前提下,尽可能地减少噪声对模型训练的影响,进而提升模型性能.Liu等[54]提出一种自适应隐私保护的APFL方案,通过分析数据集的特征向量对输出模型的影响,为不同贡献的特征向量分配不同的隐私预算ε,同时减少贡献较少的数据集的噪声,实现严格差分隐私的同时高效保证了全局模型精度与性能.Huang 等[55]针对客户端之间的不平衡数据提出DP-FL框架,其根据每个用户的数据量设置不同的差分隐私预算ε,设计具有自适应梯度下降算法的差分隐私专用卷积神经网络,来更新每个用户的训练参数,结果证明相较于传统的FL框架,该方案在不平衡数据集中表现较好.Wei等[56]将差分隐私与FL的结合做了深入的分析,证明存在最优的K值(1≤K≤总客户端数N),可以在固定的隐私保护级别上实现最佳的收敛性能.Cao 等[29]则从通信效率和隐私保护的结合出发,结合本地差分隐私,为物联网终端低算力设备提供了资源消耗的隐私保护框架. ...

VerifyNet:secure and verifiable federated learning

1

2019

... 但是,上述方案主要致力解决服务器不可信的问题,没有考虑服务器是否正确执行指定聚合操作,恶意服务器很有可能会回传虚假全局模型,蓄意破坏特定客户端对全局模型的使用.针对这类信任问题,Xu 等[57]提出具有隐私保护和模型可验证的联邦学习框架VerifyNet,通过双掩码协议保证客户端本地梯度的保密性,同时将中心服务器欺骗客户端的困难性转移到解NP-hard数学难题上,保证了全局模型的完整性和正确性. ...

Differentially private asynchronous federated learning for mobile edge computing in urban informatics

2

2019

... 随着联邦学习在移动边缘计算(MEC)和物联网(IoT)中的广泛应用,其存在的安全与隐私问题开始受到关注.Lu等[58]提出了一种差分隐私异步联邦学习(DPAFL)方案,通过将本地差分隐私引入联邦学习中,在本地模型的SGD更新中加入高斯噪声以保护隐私性,同时开发了一个新的异步联邦学习架构,它利用分布式的点对点更新方案,而不是集中式更新,以减轻集中式服务器带来的单点安全威胁,更适用于 MEC 环境.后来,Lu等[59]将这种方案应用于车载网络物理系统,解决车辆物联网环境下敏感数据泄露的问题.Hu 等[60]在异构物联网环境中使用联邦学习结合差分隐私保障用户隐私,提出一种对用户设备异质性具有鲁棒性的FL算法. ...

... 除了对联邦学习本身技术的改进,最新的研究进展包括结合边缘计算在物联网领域的应用[58,85,86,87],如图8所示.由于部分终端设备并没有足够的计算资源,同时为了满足智能决策的低时延响应,边缘计算在云中心和边缘设备之间添加了边缘服务器作为中介层,联邦学习作为其“操作系统”满足了智能边缘设备实时决策、多点协同、自主可控的要求.充分利用智能边缘服务器计算、存储、传输能力,改变传统集中上传数据进行决策的方式,破解了传统集中式机器学习数据难以聚合、隐私难以保护、云中心的单点故障等问题,为未来多功能集群、跨多智能设备的实时安全决策提供了可靠的技术保障. ...

Federated learning for data privacy preservation in vehicular cyber-physical systems

1

2020

... 随着联邦学习在移动边缘计算(MEC)和物联网(IoT)中的广泛应用,其存在的安全与隐私问题开始受到关注.Lu等[58]提出了一种差分隐私异步联邦学习(DPAFL)方案,通过将本地差分隐私引入联邦学习中,在本地模型的SGD更新中加入高斯噪声以保护隐私性,同时开发了一个新的异步联邦学习架构,它利用分布式的点对点更新方案,而不是集中式更新,以减轻集中式服务器带来的单点安全威胁,更适用于 MEC 环境.后来,Lu等[59]将这种方案应用于车载网络物理系统,解决车辆物联网环境下敏感数据泄露的问题.Hu 等[60]在异构物联网环境中使用联邦学习结合差分隐私保障用户隐私,提出一种对用户设备异质性具有鲁棒性的FL算法. ...

Personalized federated learning with differential privacy

1

2020

... 随着联邦学习在移动边缘计算(MEC)和物联网(IoT)中的广泛应用,其存在的安全与隐私问题开始受到关注.Lu等[58]提出了一种差分隐私异步联邦学习(DPAFL)方案,通过将本地差分隐私引入联邦学习中,在本地模型的SGD更新中加入高斯噪声以保护隐私性,同时开发了一个新的异步联邦学习架构,它利用分布式的点对点更新方案,而不是集中式更新,以减轻集中式服务器带来的单点安全威胁,更适用于 MEC 环境.后来,Lu等[59]将这种方案应用于车载网络物理系统,解决车辆物联网环境下敏感数据泄露的问题.Hu 等[60]在异构物联网环境中使用联邦学习结合差分隐私保障用户隐私,提出一种对用户设备异质性具有鲁棒性的FL算法. ...

Local model poisoning attacks to Byzantine-robust federated learning

1

2019

... 对于模型更新的异常检测同样是确保训练过程安全的重要方式,Fang等[61]通过客户端的本地模型发起中毒攻击使全局模型具有较大的测试错误率,并对4种拜占庭鲁棒性联邦学习框架进行了攻击研究,证明了联邦学习对局部模型中毒防御的必要性. ...

Detecting and mitigating poisoning attacks in federated learning using generative adversarial networks

1

2020

... 在联邦学习环境中,通常有数以万计的设备参与训练,服务器如果无法及时检测恶意客户端,很容易造成全局模型被污染甚至隐私泄露问题.Li等[7]提出基于检测的算法,通过一个预先训练的自动编码器神经网络来检测异常的客户行为,并消除其负面影响,给出各客户端信用评分并拒绝恶意客户端的连接.Zhao[62]等通过在服务器端部署GAN,通过客户端模型参数生成审计数据集,并利用该数据集检查参与者模型的准确性,确定是否存在中毒攻击.实验证明,该方法相比传统的模型反演方法,生成的审计数据集质量更高. ...

Incentive mechanism for reliable federated learning:a joint optimization approach to combining reputation and contract theory

1

2019

... 但是,上述提出的检测算法需要消耗服务器大量的算力审核客户端本地模型,这导致在全诚实客户端参与的联邦学习中,资源遭到极大的浪费.对此,为减少算力消耗,Kang等[63]通过经典的 RONI 中毒攻击检测算法,比较数据库中有没有相似的本地模型更新效果来判断是否中毒,然后对客户端给出信誉分以供任务发布者选择信誉值高的客户端参与训练,进而排除恶意客户端攻击的可能.Fung等[64]将这种比较放在本地模型与上一轮全局模型上,通过比较本地模型更新与全局模型更新向量方向的相似性,判断客户端是否存在恶意.Chen等[65]基于受信任的执行环境,设计了训练完整性协议用于检测不诚实的行为,如篡改本地训练模型和延迟本地训练进程,实验证明该方案具有训练完整性与实用性. ...

Mitigating sybils in federated learning poisoning

2

2018

... 但是,上述提出的检测算法需要消耗服务器大量的算力审核客户端本地模型,这导致在全诚实客户端参与的联邦学习中,资源遭到极大的浪费.对此,为减少算力消耗,Kang等[63]通过经典的 RONI 中毒攻击检测算法,比较数据库中有没有相似的本地模型更新效果来判断是否中毒,然后对客户端给出信誉分以供任务发布者选择信誉值高的客户端参与训练,进而排除恶意客户端攻击的可能.Fung等[64]将这种比较放在本地模型与上一轮全局模型上,通过比较本地模型更新与全局模型更新向量方向的相似性,判断客户端是否存在恶意.Chen等[65]基于受信任的执行环境,设计了训练完整性协议用于检测不诚实的行为,如篡改本地训练模型和延迟本地训练进程,实验证明该方案具有训练完整性与实用性. ...

... 联邦学习中的客户端可能遭受恶意攻击而上传恶意模型更新,破坏全局模型聚合过程,而区块链的审计性与可靠性结合联邦学习具有广阔的研究价值.Preuveneers等[76]提出了一个基于区块链的联邦学习模型审计方案,客户端上传的模型更新需要进行异常检测并链接到分布式分类账上,检测结果大于预定义阈值的客户端将被问责,同时为避免中心服务器的单点故障问题,区块链被用于替换中心服务器与客户端的直接交互,因此联邦学习中的每个节点都拥有一个完整的分类账副本,并且可以计算汇总的权重更新.Zhu等[77]引入区块链技术管理联邦学习的安全问题,建立安全的协同训练机制来检测客户端的可靠性.实验结果表明,当拜占庭故障设备是客户端成员的一部分时,该方案具有明显的优势.Qu 等[64]提出FL-Block方案,利用区块链的性质与其提出的增强协议能够有效抵御中毒攻击,其要求矿工在记录模型更新到区块链之前先验证其正确性,然后将模型更新存储在与其关联的候选块中.Liu等[80]在区块链中基于智能合约交互模型更新,以自动验证模型更新防御恶意和不可靠的参与者,同时引入本地差分隐私技术,防止成员推理攻击,实现了5G网络中的隐私安全FL. ...

A training-integrity privacy-preserving federated learning scheme with trusted execution environment

1

2020

... 但是,上述提出的检测算法需要消耗服务器大量的算力审核客户端本地模型,这导致在全诚实客户端参与的联邦学习中,资源遭到极大的浪费.对此,为减少算力消耗,Kang等[63]通过经典的 RONI 中毒攻击检测算法,比较数据库中有没有相似的本地模型更新效果来判断是否中毒,然后对客户端给出信誉分以供任务发布者选择信誉值高的客户端参与训练,进而排除恶意客户端攻击的可能.Fung等[64]将这种比较放在本地模型与上一轮全局模型上,通过比较本地模型更新与全局模型更新向量方向的相似性,判断客户端是否存在恶意.Chen等[65]基于受信任的执行环境,设计了训练完整性协议用于检测不诚实的行为,如篡改本地训练模型和延迟本地训练进程,实验证明该方案具有训练完整性与实用性. ...

Towards fair and privacy-preserving federated deep models

2020

FLchain:federated learning via MEC-enabled blockchain network

1

2019

... 联邦学习中,由于服务器的中心聚合作用,其设备一旦受到敌手单点攻击就会对整个学习框架造成很大的安全隐患.为提升框架的安全性、可信性、可靠性,Majeed等[67]提出基于区块链的FLchain 架构,以提升联邦学习的安全性,在FLchain 中,对于每个全局模型,框架都会创建一个新的通道来存储特定通道分类账,同时创建“全局模型状态树”来跟踪全局模型的权重更新, FLchain以一种不可篡改的方式保证了FL模型的起源性和可审计性.Sharma等[43]在分布式多层计算框架的基础上使用离线区块链和在线区块链实时存储大量节点的临时训练数据,利用多层和多链结构有效减少网络故障、恶意攻击对联邦学习的影响,但没有将区块链的激励机制作为提升模型性能的辅助措施.Arachchige 等[68]通过融合差分隐私、联邦学习、以太坊区块链和智能合约构建了名为PriModChain的框架,为联邦学习在工业物联网中的应用提供了隐私性、安全性与可靠性,但该框架的运行效率限制了其进一步的发展.Lu等[69]提出了一种新的混合区块链架构,其由许可区块链和本地有向无环图(DAG)组成,以实现车联网中的有效数据共享,提升学习模型的可靠性.Pokhrel等[70]通过私有区块链提出一种多级信任框架,以实现本地模型更新从观察到学习和验证的端到端可信性. ...

A trustworthy privacy preserving framework for machine learning in industrial iot systems

1

2020

... 联邦学习中,由于服务器的中心聚合作用,其设备一旦受到敌手单点攻击就会对整个学习框架造成很大的安全隐患.为提升框架的安全性、可信性、可靠性,Majeed等[67]提出基于区块链的FLchain 架构,以提升联邦学习的安全性,在FLchain 中,对于每个全局模型,框架都会创建一个新的通道来存储特定通道分类账,同时创建“全局模型状态树”来跟踪全局模型的权重更新, FLchain以一种不可篡改的方式保证了FL模型的起源性和可审计性.Sharma等[43]在分布式多层计算框架的基础上使用离线区块链和在线区块链实时存储大量节点的临时训练数据,利用多层和多链结构有效减少网络故障、恶意攻击对联邦学习的影响,但没有将区块链的激励机制作为提升模型性能的辅助措施.Arachchige 等[68]通过融合差分隐私、联邦学习、以太坊区块链和智能合约构建了名为PriModChain的框架,为联邦学习在工业物联网中的应用提供了隐私性、安全性与可靠性,但该框架的运行效率限制了其进一步的发展.Lu等[69]提出了一种新的混合区块链架构,其由许可区块链和本地有向无环图(DAG)组成,以实现车联网中的有效数据共享,提升学习模型的可靠性.Pokhrel等[70]通过私有区块链提出一种多级信任框架,以实现本地模型更新从观察到学习和验证的端到端可信性. ...

Blockchain empowered asynchronous federated learning for secure data sharing in internet of vehicles

1

2020

... 联邦学习中,由于服务器的中心聚合作用,其设备一旦受到敌手单点攻击就会对整个学习框架造成很大的安全隐患.为提升框架的安全性、可信性、可靠性,Majeed等[67]提出基于区块链的FLchain 架构,以提升联邦学习的安全性,在FLchain 中,对于每个全局模型,框架都会创建一个新的通道来存储特定通道分类账,同时创建“全局模型状态树”来跟踪全局模型的权重更新, FLchain以一种不可篡改的方式保证了FL模型的起源性和可审计性.Sharma等[43]在分布式多层计算框架的基础上使用离线区块链和在线区块链实时存储大量节点的临时训练数据,利用多层和多链结构有效减少网络故障、恶意攻击对联邦学习的影响,但没有将区块链的激励机制作为提升模型性能的辅助措施.Arachchige 等[68]通过融合差分隐私、联邦学习、以太坊区块链和智能合约构建了名为PriModChain的框架,为联邦学习在工业物联网中的应用提供了隐私性、安全性与可靠性,但该框架的运行效率限制了其进一步的发展.Lu等[69]提出了一种新的混合区块链架构,其由许可区块链和本地有向无环图(DAG)组成,以实现车联网中的有效数据共享,提升学习模型的可靠性.Pokhrel等[70]通过私有区块链提出一种多级信任框架,以实现本地模型更新从观察到学习和验证的端到端可信性. ...

Towards efficient and reliable federated learning using blockchain for autonomous vehicles

1

2020

... 联邦学习中,由于服务器的中心聚合作用,其设备一旦受到敌手单点攻击就会对整个学习框架造成很大的安全隐患.为提升框架的安全性、可信性、可靠性,Majeed等[67]提出基于区块链的FLchain 架构,以提升联邦学习的安全性,在FLchain 中,对于每个全局模型,框架都会创建一个新的通道来存储特定通道分类账,同时创建“全局模型状态树”来跟踪全局模型的权重更新, FLchain以一种不可篡改的方式保证了FL模型的起源性和可审计性.Sharma等[43]在分布式多层计算框架的基础上使用离线区块链和在线区块链实时存储大量节点的临时训练数据,利用多层和多链结构有效减少网络故障、恶意攻击对联邦学习的影响,但没有将区块链的激励机制作为提升模型性能的辅助措施.Arachchige 等[68]通过融合差分隐私、联邦学习、以太坊区块链和智能合约构建了名为PriModChain的框架,为联邦学习在工业物联网中的应用提供了隐私性、安全性与可靠性,但该框架的运行效率限制了其进一步的发展.Lu等[69]提出了一种新的混合区块链架构,其由许可区块链和本地有向无环图(DAG)组成,以实现车联网中的有效数据共享,提升学习模型的可靠性.Pokhrel等[70]通过私有区块链提出一种多级信任框架,以实现本地模型更新从观察到学习和验证的端到端可信性. ...

On-device federated learning via blockchain and its latency analysis

1

2018

... 联邦学习框架不仅存在单点故障问题,在没有良好激励机制的情况下参与训练的客户端可能会不上传或上传虚假的模型更新.针对激励机制的设计,Kim等[71]提出了BlockFL架构,其中每个设备将本地模型更新上传给区块链网络中的关联矿工,矿工负责对模型更新进行交换和验证后记录到区块链中,并提供相应的奖励.Kang等[72]引入声誉概念作为客户端信任度的衡量指标,利用多权重的主观逻辑模型设计了基于声誉的可信客户端选择方案,同时通过区块链的不可篡改性实现分布式的信誉管理,并使用契约理论分析参与构建模型的客户端的算力投入、模型质量等因素给予相对应的回报.Weng[73]等提出DeepChain方案,通过区分客户端在训练过程中表现的活性和兼容性,促使客户端发送正确的、高质量的模型更新,同时使用区块链技术保证模型安全和训练过程的可审核性,实现保密性、可审核和公平公正的目标.Kim等[74]通过区块链技术对所有的模型更新进行完整的记录,并给予丰厚的奖励来激励用户参与联邦学习,提出了基于权重的客户端子集选择方案,通过每个客户端局部模型的精度和参与训练的频率来选择用于训练的客户端,实现了较高的稳定性和较快的收敛速度.Zhan等[75]设计了一种基于深度强化学习的(DRL)激励机制,将传统的资源分配策略应用于 FL 分布式特殊场景,以达到边缘节点的最佳训练策略和定价策略. ...

Incentive mechanism for reliable federated learning:a joint optimization approach to combining reputation and contract theory

1

2019

... 联邦学习框架不仅存在单点故障问题,在没有良好激励机制的情况下参与训练的客户端可能会不上传或上传虚假的模型更新.针对激励机制的设计,Kim等[71]提出了BlockFL架构,其中每个设备将本地模型更新上传给区块链网络中的关联矿工,矿工负责对模型更新进行交换和验证后记录到区块链中,并提供相应的奖励.Kang等[72]引入声誉概念作为客户端信任度的衡量指标,利用多权重的主观逻辑模型设计了基于声誉的可信客户端选择方案,同时通过区块链的不可篡改性实现分布式的信誉管理,并使用契约理论分析参与构建模型的客户端的算力投入、模型质量等因素给予相对应的回报.Weng[73]等提出DeepChain方案,通过区分客户端在训练过程中表现的活性和兼容性,促使客户端发送正确的、高质量的模型更新,同时使用区块链技术保证模型安全和训练过程的可审核性,实现保密性、可审核和公平公正的目标.Kim等[74]通过区块链技术对所有的模型更新进行完整的记录,并给予丰厚的奖励来激励用户参与联邦学习,提出了基于权重的客户端子集选择方案,通过每个客户端局部模型的精度和参与训练的频率来选择用于训练的客户端,实现了较高的稳定性和较快的收敛速度.Zhan等[75]设计了一种基于深度强化学习的(DRL)激励机制,将传统的资源分配策略应用于 FL 分布式特殊场景,以达到边缘节点的最佳训练策略和定价策略. ...

Deepchain:auditable and privacy-preserving deep learning with blockchain-based incentive

1

2019

... 联邦学习框架不仅存在单点故障问题,在没有良好激励机制的情况下参与训练的客户端可能会不上传或上传虚假的模型更新.针对激励机制的设计,Kim等[71]提出了BlockFL架构,其中每个设备将本地模型更新上传给区块链网络中的关联矿工,矿工负责对模型更新进行交换和验证后记录到区块链中,并提供相应的奖励.Kang等[72]引入声誉概念作为客户端信任度的衡量指标,利用多权重的主观逻辑模型设计了基于声誉的可信客户端选择方案,同时通过区块链的不可篡改性实现分布式的信誉管理,并使用契约理论分析参与构建模型的客户端的算力投入、模型质量等因素给予相对应的回报.Weng[73]等提出DeepChain方案,通过区分客户端在训练过程中表现的活性和兼容性,促使客户端发送正确的、高质量的模型更新,同时使用区块链技术保证模型安全和训练过程的可审核性,实现保密性、可审核和公平公正的目标.Kim等[74]通过区块链技术对所有的模型更新进行完整的记录,并给予丰厚的奖励来激励用户参与联邦学习,提出了基于权重的客户端子集选择方案,通过每个客户端局部模型的精度和参与训练的频率来选择用于训练的客户端,实现了较高的稳定性和较快的收敛速度.Zhan等[75]设计了一种基于深度强化学习的(DRL)激励机制,将传统的资源分配策略应用于 FL 分布式特殊场景,以达到边缘节点的最佳训练策略和定价策略. ...

Blockchain-based node-aware dynamic weighting methods for improving federated learning performance

1

2019

... 联邦学习框架不仅存在单点故障问题,在没有良好激励机制的情况下参与训练的客户端可能会不上传或上传虚假的模型更新.针对激励机制的设计,Kim等[71]提出了BlockFL架构,其中每个设备将本地模型更新上传给区块链网络中的关联矿工,矿工负责对模型更新进行交换和验证后记录到区块链中,并提供相应的奖励.Kang等[72]引入声誉概念作为客户端信任度的衡量指标,利用多权重的主观逻辑模型设计了基于声誉的可信客户端选择方案,同时通过区块链的不可篡改性实现分布式的信誉管理,并使用契约理论分析参与构建模型的客户端的算力投入、模型质量等因素给予相对应的回报.Weng[73]等提出DeepChain方案,通过区分客户端在训练过程中表现的活性和兼容性,促使客户端发送正确的、高质量的模型更新,同时使用区块链技术保证模型安全和训练过程的可审核性,实现保密性、可审核和公平公正的目标.Kim等[74]通过区块链技术对所有的模型更新进行完整的记录,并给予丰厚的奖励来激励用户参与联邦学习,提出了基于权重的客户端子集选择方案,通过每个客户端局部模型的精度和参与训练的频率来选择用于训练的客户端,实现了较高的稳定性和较快的收敛速度.Zhan等[75]设计了一种基于深度强化学习的(DRL)激励机制,将传统的资源分配策略应用于 FL 分布式特殊场景,以达到边缘节点的最佳训练策略和定价策略. ...

A learning-based incentive mechanism for federated learning

1

2020

... 联邦学习框架不仅存在单点故障问题,在没有良好激励机制的情况下参与训练的客户端可能会不上传或上传虚假的模型更新.针对激励机制的设计,Kim等[71]提出了BlockFL架构,其中每个设备将本地模型更新上传给区块链网络中的关联矿工,矿工负责对模型更新进行交换和验证后记录到区块链中,并提供相应的奖励.Kang等[72]引入声誉概念作为客户端信任度的衡量指标,利用多权重的主观逻辑模型设计了基于声誉的可信客户端选择方案,同时通过区块链的不可篡改性实现分布式的信誉管理,并使用契约理论分析参与构建模型的客户端的算力投入、模型质量等因素给予相对应的回报.Weng[73]等提出DeepChain方案,通过区分客户端在训练过程中表现的活性和兼容性,促使客户端发送正确的、高质量的模型更新,同时使用区块链技术保证模型安全和训练过程的可审核性,实现保密性、可审核和公平公正的目标.Kim等[74]通过区块链技术对所有的模型更新进行完整的记录,并给予丰厚的奖励来激励用户参与联邦学习,提出了基于权重的客户端子集选择方案,通过每个客户端局部模型的精度和参与训练的频率来选择用于训练的客户端,实现了较高的稳定性和较快的收敛速度.Zhan等[75]设计了一种基于深度强化学习的(DRL)激励机制,将传统的资源分配策略应用于 FL 分布式特殊场景,以达到边缘节点的最佳训练策略和定价策略. ...

Chained anomaly detection models for federated learning:an intrusion detection case study

1

2018

... 联邦学习中的客户端可能遭受恶意攻击而上传恶意模型更新,破坏全局模型聚合过程,而区块链的审计性与可靠性结合联邦学习具有广阔的研究价值.Preuveneers等[76]提出了一个基于区块链的联邦学习模型审计方案,客户端上传的模型更新需要进行异常检测并链接到分布式分类账上,检测结果大于预定义阈值的客户端将被问责,同时为避免中心服务器的单点故障问题,区块链被用于替换中心服务器与客户端的直接交互,因此联邦学习中的每个节点都拥有一个完整的分类账副本,并且可以计算汇总的权重更新.Zhu等[77]引入区块链技术管理联邦学习的安全问题,建立安全的协同训练机制来检测客户端的可靠性.实验结果表明,当拜占庭故障设备是客户端成员的一部分时,该方案具有明显的优势.Qu 等[64]提出FL-Block方案,利用区块链的性质与其提出的增强协议能够有效抵御中毒攻击,其要求矿工在记录模型更新到区块链之前先验证其正确性,然后将模型更新存储在与其关联的候选块中.Liu等[80]在区块链中基于智能合约交互模型更新,以自动验证模型更新防御恶意和不可靠的参与者,同时引入本地差分隐私技术,防止成员推理攻击,实现了5G网络中的隐私安全FL. ...

Blockchain-based privacy preserving deep learning

1

2018

... 联邦学习中的客户端可能遭受恶意攻击而上传恶意模型更新,破坏全局模型聚合过程,而区块链的审计性与可靠性结合联邦学习具有广阔的研究价值.Preuveneers等[76]提出了一个基于区块链的联邦学习模型审计方案,客户端上传的模型更新需要进行异常检测并链接到分布式分类账上,检测结果大于预定义阈值的客户端将被问责,同时为避免中心服务器的单点故障问题,区块链被用于替换中心服务器与客户端的直接交互,因此联邦学习中的每个节点都拥有一个完整的分类账副本,并且可以计算汇总的权重更新.Zhu等[77]引入区块链技术管理联邦学习的安全问题,建立安全的协同训练机制来检测客户端的可靠性.实验结果表明,当拜占庭故障设备是客户端成员的一部分时,该方案具有明显的优势.Qu 等[64]提出FL-Block方案,利用区块链的性质与其提出的增强协议能够有效抵御中毒攻击,其要求矿工在记录模型更新到区块链之前先验证其正确性,然后将模型更新存储在与其关联的候选块中.Liu等[80]在区块链中基于智能合约交互模型更新,以自动验证模型更新防御恶意和不可靠的参与者,同时引入本地差分隐私技术,防止成员推理攻击,实现了5G网络中的隐私安全FL. ...

Decentralized privacy using blockchain-enabled federated learning in fog computing

2020

A secure federated learning framework for 5G networks

1

2020

... (4)智慧城市.随着人工智能、物联网和5G技术的发展,智慧城市的概念已经跃然纸上.然而,在城市的不同信息部门中,如后勤、应急、维稳、安保等,会产生大量的异构数据,形成多个数据孤岛,无法整合利用.联邦学习的异构数据处理能力能够帮助人们创造迅速响应市民需求的智慧城市,解决数据“孤岛”问题,同时基于智慧城市构建的机器学习模型为企业提供个性化服务带来了更多的机遇[79]. ...

Advances and open problems in federated learning

2

2019

... 联邦学习中的客户端可能遭受恶意攻击而上传恶意模型更新,破坏全局模型聚合过程,而区块链的审计性与可靠性结合联邦学习具有广阔的研究价值.Preuveneers等[76]提出了一个基于区块链的联邦学习模型审计方案,客户端上传的模型更新需要进行异常检测并链接到分布式分类账上,检测结果大于预定义阈值的客户端将被问责,同时为避免中心服务器的单点故障问题,区块链被用于替换中心服务器与客户端的直接交互,因此联邦学习中的每个节点都拥有一个完整的分类账副本,并且可以计算汇总的权重更新.Zhu等[77]引入区块链技术管理联邦学习的安全问题,建立安全的协同训练机制来检测客户端的可靠性.实验结果表明,当拜占庭故障设备是客户端成员的一部分时,该方案具有明显的优势.Qu 等[64]提出FL-Block方案,利用区块链的性质与其提出的增强协议能够有效抵御中毒攻击,其要求矿工在记录模型更新到区块链之前先验证其正确性,然后将模型更新存储在与其关联的候选块中.Liu等[80]在区块链中基于智能合约交互模型更新,以自动验证模型更新防御恶意和不可靠的参与者,同时引入本地差分隐私技术,防止成员推理攻击,实现了5G网络中的隐私安全FL. ...

... 不同于传统的分布式机器学习技术,海量客户端与Non-IID数据集对联邦学习提出了新的挑战.目前,学术界对于联邦学习的研究十分活跃,研究者可能不仅需要掌握机器学习技术,还需要掌握分布式算法优化、密码学、压缩量化、信息论、统计等技术[80].本文介绍了联邦学习在通信效率、隐私安全、信任与激励机制等方向上的研究进展,但仍有一些其他研究方向值得探索. ...

Federated learning:challenges,methods,and future directions

1

2019

... (1)系统异构.在联邦学习环境中,由于参与训练的客户端之间硬件配置、网络带宽、电池容量等不同,各终端设备的计算能力、通信速度和存储能力各不相同[81].除此之外,联邦学习架构通常会限制终端设备参与训练的数量,尤其是在数百万设备参与的训练中,处于活跃状态的往往只有数百个客户端.每个客户端并不一定可靠,随时可能因为网络故障、算力限制等问题退出现有训练,这些系统级别的异构会给模型整体效能造成极大的挑战.因此,适用于系统异构的联邦学习算法必须满足3点要求:客户端的低参与率;兼容不同的硬件结构;能够容忍训练设备的中途退出. ...

Federated multi-task learning

1

2017

... (2)统计异构.不同的终端设备通常使用各式各样的方式生成、存储和传输数据,因此各设备之间数据的特征和体量可能有很大的不同,导致数据呈Non-IID分布和非平衡分布.尽管这类分布的数据集可以通过通信效率优化的方式处理,但仍然存在一些针对统计异构的解决方法,如通过多任务学习框架学习不同的局部模型[82].类似于元学习,多任务学习由于对个性化和特定于设备建模的支持,已经成为解决数据统计异构性的主流方法. ...

Robust federated learning with noisy communication

1

2020

... (3)无线通信.在5G技术日益普及的今天,联邦学习开始被逐渐应用于无线网络领域.由于无线信道的带宽容量有限,因此在发送信息之前,需要对模型更新进行量化压缩,在这种模式下,一个重要的考虑因素是存在量化误差时模型更新的鲁棒性.除了通信带宽外,无线通信中复杂的噪声和干扰也是加剧信道瓶颈的因素[83].因此,开发适用于无线通信的联邦学习算法具有突出的研究意义[84]. ...

Federated learning for wireless communications:motivation,opportunities,and challenges

1

2020

... (3)无线通信.在5G技术日益普及的今天,联邦学习开始被逐渐应用于无线网络领域.由于无线信道的带宽容量有限,因此在发送信息之前,需要对模型更新进行量化压缩,在这种模式下,一个重要的考虑因素是存在量化误差时模型更新的鲁棒性.除了通信带宽外,无线通信中复杂的噪声和干扰也是加剧信道瓶颈的因素[83].因此,开发适用于无线通信的联邦学习算法具有突出的研究意义[84]. ...

Federated learning-based computation offloading optimization in edge computing-supported internet of things

1

2019

... 除了对联邦学习本身技术的改进,最新的研究进展包括结合边缘计算在物联网领域的应用[58,85,86,87],如图8所示.由于部分终端设备并没有足够的计算资源,同时为了满足智能决策的低时延响应,边缘计算在云中心和边缘设备之间添加了边缘服务器作为中介层,联邦学习作为其“操作系统”满足了智能边缘设备实时决策、多点协同、自主可控的要求.充分利用智能边缘服务器计算、存储、传输能力,改变传统集中上传数据进行决策的方式,破解了传统集中式机器学习数据难以聚合、隐私难以保护、云中心的单点故障等问题,为未来多功能集群、跨多智能设备的实时安全决策提供了可靠的技术保障. ...

In-edge AI:intelligentizing mobile edge computing,caching and communication by federated learning

1

2019

... 除了对联邦学习本身技术的改进,最新的研究进展包括结合边缘计算在物联网领域的应用[58,85,86,87],如图8所示.由于部分终端设备并没有足够的计算资源,同时为了满足智能决策的低时延响应,边缘计算在云中心和边缘设备之间添加了边缘服务器作为中介层,联邦学习作为其“操作系统”满足了智能边缘设备实时决策、多点协同、自主可控的要求.充分利用智能边缘服务器计算、存储、传输能力,改变传统集中上传数据进行决策的方式,破解了传统集中式机器学习数据难以聚合、隐私难以保护、云中心的单点故障等问题,为未来多功能集群、跨多智能设备的实时安全决策提供了可靠的技术保障. ...

Adaptive federated learning in resource constrained edge computing systems

1

2019

... 除了对联邦学习本身技术的改进,最新的研究进展包括结合边缘计算在物联网领域的应用[58,85,86,87],如图8所示.由于部分终端设备并没有足够的计算资源,同时为了满足智能决策的低时延响应,边缘计算在云中心和边缘设备之间添加了边缘服务器作为中介层,联邦学习作为其“操作系统”满足了智能边缘设备实时决策、多点协同、自主可控的要求.充分利用智能边缘服务器计算、存储、传输能力,改变传统集中上传数据进行决策的方式,破解了传统集中式机器学习数据难以聚合、隐私难以保护、云中心的单点故障等问题,为未来多功能集群、跨多智能设备的实时安全决策提供了可靠的技术保障. ...