1 引言

人脸识别因其巨大的应用潜力吸引了计算机视觉、机器学习和模式识别领域的大量研究人员,在过去的二十年中诞生了许多算法[1 ,2 ,3 ,4 ,5 ,6 ,7 ,8 ] 。一些众所周知的人脸识别方法,例如基于主成分分析(principal component analysis,PCA)的Eigenfaces[9 ] 、基于线性判别分析(linear discriminant analysis,LDA)的Fisherfaces[10 ] 、基于独立成分分析(independent component analysis,ICA)的Independentfaces[11 ] 和基于局部保留投影(locality preserving projection, LPP)的Laplacianfaces[12 ] ,已经获得了较好的成果,然而这些方法对噪声和异常值很敏感。

Li S Z等人[13 ] 提出了一种最近特征线(nearest feature line,NFL)分类方法,该方法使用线性方式对属于同一类的每对训练样本进行外推和内插。NFL可以泛化样本的代表性能力,并已被广泛应用于许多模式识别任务中[14 ] 。沿着这个研究方向, Chien J T等人[15 ] 提出了一种最近特征空间(nearest feature space,NFS)分类方法。NFS中构建每个类的特征空间的方式与NFL中构建特征线的方式类似。

近年来,研究人员们在假设测试图像位于由同一类图像组成的线性子空间的条件下,提出了一些基于线性表示的新型分类算法[16 ,17 ,18 ,19 ,20 ,21 ,22 ] 。Wright J 等人[16 ] 提出了一种基于稀疏表示的分类器 SRC(sparse representation classifier),SRC在人脸识别方面取得了较好的结果。SRC使用所有训练样本来制定一个过完备字典,然后通过L1 最小化问题在训练样本上对探测图像进行稀疏编码。SRC得到的大部分组合系数很小,接近于零,只有小部分组合系数具有显著值,因此可以使用非零系数来确定探测图像的标签。

尽管SRC在鲁棒人脸识别问题上非常成功,但对于存在连续遮挡的人脸图片,其鲁棒性仍然不够高[23 ] ,且计算复杂度非常高。为了解决这个问题, He R 等人[22 ] 提出了一种基于相关熵的稀疏表示(correntropy based sparse representation,CESR)方法。相关熵[24 -25 ] 与M估计(M-estimation)密切相关,可以有效地处理噪声和大的异常值[26 -27 ] 。实验结果表明,对于人脸识别中的围巾遮挡问题,CESR的识别率高于SRC。

然而,参考文献[28 ]认为SRC中用于约束的L1 范数可以用L2 范数代替,这是因为真实人脸图像不支持SRC的稀疏假设。同样,Zhang L等人[21 ] 认为协同表示的方法可以获得比使用L1 范数的SRC更好的结果。因此,Zhang L 等人[21 ] 提出了一种基于协同表示的分类方法 CRC(collaborative representation based classification),CRC使用L2 范数而获得了解析解,因此其展现出比SRC更优秀的性能。

参考文献[17 ]提出了另一种同样使用L2 范数的有效的基于线性回归的分类方法 LRC(linear regression-based classification)。与 CRC 相比,LRC仅使用来自特定类别的图像获取表示系数。Ren C X等人[19 ] 提出了一种基于L2,1 范数的分类方法,称为基于旋转不变范数的回归分类(rotational inva riant norm based regression for classification,RRC)方法,L2,1 范数是旋转不变的,且比 L2 范数对噪声和异常值的处理更具鲁棒性。Ren C X 等人[19 ] 还为RRC开发了一种高效的优化算法,这与Nie F P等人[29 ] 提出的优化算法非常相似。

流形学习的成功表明局部几何信息对构建学习算法非常重要[12 ,30 ,31 ,32 ,33 ,34 ,35 ,36 ,37 ,38 ] 。参考文献[38 -39 ]认为局部性比稀疏性更重要,这是因为局部性总会导致稀疏性,但反过来不一定成立。在局部约束下,L2范数也可以产生近似稀疏的表示结果。

利用相关熵和局部约束的优点,笔者提出了一种基于最大相关熵和局部约束的协同表示分类器(collaborative representation based classifierwith maximum correntropy criterion and locality information,CRC/MCCLC)。对于异常值, CRC/MCCLC 比 L1 范数的鲁棒性更高,且由于使用了最大相关熵准则,CRC/MCCLC还可以使用半二次优化技术进行更有效的计算。此外, CRC/MCCLC 可以从训练样本中获得更多的判别信息,并且由于使用了局部信息,CRC/MCCLC可以获得近似稀疏的表示结果。本文还提出了一种用于实现 CRC/MCCLC 的有效优化算法。在一些图像数据集上的大量实验结果证明了 CRC/MCCLC的有效性。

(1)本文将相关熵和流形学习集成到一个无缝模型中,因此本文提出的方法不仅可以有效地处理非高斯噪声和异常值,还可以获得近似稀疏的表示结果。

(2)笔者分析了CRC/MCCLC的优化问题。基于半二次优化技术,笔者提出了一种求解CRC/MCCLC的有效程序。

本文其余部分安排如下:第 2 节简要回顾了SRC、CRC和相关熵;第3节提出了CRC/MCCLC方法,并为其优化问题提出了一种有效的基于半二次优化的算法;第4节介绍本文所做的实验;第5节总结全文。

2 局部约束与熵

2.1 SRC与CRC

给定一个数据矩阵X = { x 1 , x 2 , ⋯ , x n } [ X 1 , ⋯ , X c ] ∈ R d × n x i ∈ R d ( i = 1 , 2 , ⋯ , n ) X i ∈ R d × n i ( i = 1 , 2 , ⋯ , c ) ∑ i = 1 c n i = n y ∈ R d

y ≈ X i β i , i = 1 , 2 , ⋯ , c ( 1 )

其中,β i ∈ R n i y

y ≈ X β ( 2 )

min β ‖ β ‖ 0 , s .t . y = X β ( 3 )

其中, ‖ ⋅ ‖ 0 0 范数,即求β 0 最小化问题转为 L1 最小化问题进行求解,如式(4)所示:

min β ‖ β ‖ 1 , s .t . y = X β ( 4 )

其中, ‖ ⋅ ‖ 1 1 范数, ‖ β ‖ 1 = ∑ i = 1 n | β i |

min β ‖ β ‖ 1 , s . t . ‖ y − X β ‖ 2 ≤ ε ( 5 )

其中,ε>0为容错量。该模型可以有效地解决遮挡和损坏问题。

通常,式(5)可以被重写为具有适当参数λ≥0的等效无约束形式:

min β ‖ y − X β ‖ 2 2 + λ ‖ β ‖ 1 ( 6 )

式(6)被称为套索问题。在接下来的部分中,笔者将式(6)作为SRC的目标函数。

CRC[21 ] 仅用L2 范数代替式(6)中的L1 范数就可以得到较高的识别率。CRC的目标函数为:

min β ‖ y − X β ‖ 2 2 + λ ‖ β ‖ 2 2 ( 7 )

CRC存在解析解,如β = ( X ⊤ X + λ I ) − 1 X ⊤ y I

2.2 熵

熵[24 -25 ] 被定义为两个任意变量A和B之间的局部相似性度量:

V σ ( A , B ) = E [ k σ ( A − B ) ] ( 8 )

其中,E[⋅]是数学期望,kσ (⋅)表示核函数。通常只能获得数量有限的数据 { ( a j , b j ) } j = 1 n

V ^ n , σ ( A , B ) = 1 n ∑ j = 1 n k σ ( a j − b j ) ( 9 )

其中,kσ 是高斯核函数 g ( x ) = exp ( − x 2 2 σ 2 )

V ^ n , σ ( A , B ) = 1 n ∑ j = 1 n g ( a j − b j ) ( 10 )

在参考文献[24 ]中,最大相关熵准则(maximum correntropy criterion,MCC)被定义为误差的最大相关熵。

3 基于最大相关熵和局部约束的协同表示分类器

3.1 算法模型

‖ y − X β ‖ 2 2 = ∑ j = 1 d ( y j − ∑ i = 1 n x i j β i ) 2 ( 11 )

其中,xij 表示第i个训练样本的第j项,y j 表示y的第j项。

将式(11)代入式(7),再结合式(10),同时给出具有局部约束W β

J CRC/MCCLC = max β ∑ j = 1 d g ( y j − ∑ i = 1 n x i j β i ) − λ ‖ W β ‖ 2 2 ( 12 )

其中,W = diag ( [ w 1 , w 2 , ⋯ , w n ] ) w i ( i = 1 , 2 , ⋯ , n ) x i y

w i = exp ( ‖ y − x i ‖ 2 / σ 2 ) max ( exp ( ‖ y − x i ‖ 2 / σ 2 ) ) , i = 1 , 2 , ⋯ , n ( 13 )

式(12)中的局部约束 W y x i y x i

3.2 CRC/MCCLC的目标函数的求解算法

由于 CRC/MCCLC 的求解是一个非线性优化问题,很难直接进行优化。因此,笔者设计了一种基于半二次优化技术求解式(12)的算法[27 ] 。

定理1[22 ,27 ] 存在g(x)的凸共轭函数ϕ使得:

g ( x ) = max p ′ ( p ′ ‖ x ‖ 2 σ 2 − φ ( p ′ ) ) ( 14 )

其中,p ′ ∈ R p ′ = − g ( x )

将式(14)代入式(12),得到 CRC/MCCLC的增强目标函数:

J ^ CRC/MCCLC =

max β , p ∑ j = 1 d ( p j ( y j − ∑ i = 1 n x i j β i ) 2 − φ ( p j ) ) − λ ‖ W β ‖ 2 2 ( 15 )

其中,p = [ p 1 , p 2 , ⋯ , p d ] ⊤ β

J CRC/MCCLC ( β ) = max p J ^ CRC/MCCLC ( β , p ) ( 16 )

max β J CRC/MCCLC ( β ) = max β , p J ^ CRC/MCCLC ( β , p ) ( 17 )

因此,可以通过最大化 J ^ CRC/MCCLC ( β , p ) J CRC/MCCLC ( β )

p j t + 1 = − g ( y j − ∑ i = 1 n x i j β i t ) ( 18 )

β t + 1 = arg max β ( y − X β ) ⊤ diag ( p ) ( y − X β ) − λ ‖ W β ‖ 2 2 ( 19 )

arg max β β ⊤ X ⊤ diag ( p ) X β − y ⊤ diag ( p ) X β −

β ⊤ X ⊤ diag ( p ) y − λ β ⊤ W ⊤ W β ( 20 )

令X ˜ = diag ( − p t + 1 ) X y ˜ = diag ( − p t + 1 ) y

arg min β β ⊤ X ˜ ⊤ X ˜ β − y ˜ ⊤ X ˜ β − β ⊤ X ˜ ⊤ y ˜ + λ β ⊤ W ⊤ W β ( 21 )

β = ( X ˜ ⊤ X ˜ + λ W ⊤ W ) − 1 X ˜ ⊤ y ˜ ( 22 )

根据以上分析,式(15)的优化过程可总结为算法1。

输入 数据矩阵 X y p 1 = − [ 1 , 1 , ⋯ , 1 ] ∈ R d

步骤 2:计算X ˜ = diag ( − p t ) X diag ( − p t ) y

步骤4:如果‖ β t − β t − 1 ‖ < ε p t + 1

由以上算法可以看出,CRC/MCCLCC 生成的序列 { J ^ CRC/MCCLC ( β , p ) , t = 1 , 2 , ⋯ }

3.3 CRC/MCCLC的分类过程

通常,计算分类器需要将测试样本y y y

因此,笔者将测试样本y δ i : R n → R n i δ i ( β ) ∈ R n i ( i = 1 , 2 , ⋯ , c ) β y

y ^ i = X i δ i ( β ) ( 23 )

因此,测试样本y y y ^ i

max i r i ( y ) = g ( ‖ y − y ^ i ‖ 2 ) = g ( ‖ y − X i δ i ( β ) ‖ 2 ) =

exp ( − ‖ y − X i δ i ( β ) ‖ 2 2 2 σ 2 ) ( 24 )

由于 g(x)是一个单调递减函数,y y ^ i y y ^ i

min i r i ( y ) = ‖ y − y ^ i ‖ 2 = ‖ y − X i δ i ( β ) i ‖ 2 ( 25 )

根据以上分析,CRC/MCCLC的分类过程可总结为算法 2。

输入 数据矩阵X = [ X 1 , ⋯ , X c ] ∈ R d × n y β

步骤2:计算残差 r i ( y ) = ‖ y − y ^ i ‖ 2 = ‖ y − X i δ i ( β ) i ‖ 2

步骤3:identity( y ) = arg max i r i ( y )

3.4 算法复杂度

在算法1的步骤1中,计算W X ˜ = diag ( − p t ) X y ˜ = diag ( − p t ) y β 2 )。由此可以得出,CRC/MCCLC的算法复杂度为O ( t ( d n 2 + d n + d ) )

4 实验与结果

本节在人脸识别方面将本文提出的 CRC/MCCLC与几种相关的先进算法进行比较,如SRC[16 ] 、CRC[21 ] 、LRC[17 ] 以及CESR[22 ] 。SRC是使用l1-magic实现的,是一个公开可用的数据包。对于CRC/MCCLC中的σ和λ,笔者尝试从{0.1, 0.5, 1, 5, 10, 50}与{0.001, 0.002, 0.003, 0.004, 0.005, 0.006, 0.007, 0.008, 0.009, 0.010}中分别取不同的值进行测试。实验是在移动双核Intel Pentium(1.8 GHz)处理器、4G RAM的acer计算机上进行的,实验所用操作系统为Windows7,编程环境为MATLAB2008。

4.1 ORL人脸数据集上的实验

ORL 人脸数据集中共有 400 张人脸图像(共40人,每人10个样本)。某些人脸图像是在不同时间拍摄的,灯光、面部动作(睁眼/闭眼、微笑/不微笑)和面部细节(戴眼镜/不戴眼镜)都不同。ORL人脸数据集中某人的一些示例图像如图1 所示。

实验选取每个人的i(i=4,5)个样本进行训练,其余样本用于测试。对于每个给定的i,执行10次随机选择样本操作并训练样本,然后计算平均识别率和标准偏差。实验中,PCA被用于降低每个图像的维数。不同算法在 ORL 人脸数据集上的平均识别率和标准偏差见表1 。从表1 可以看出,本文提出的算法 CRC/MCCLC 较原有算法在误差允许范围内有明显的效果提升。

图1

4.2 Yale人脸数据集上的实验

Yale人脸数据集包含15个人的165张灰度图像,每个人有 11 张图像。这些图像展示了光照条件、面部表情(正常、快乐、悲伤、困倦、惊讶和眨眼)的变化。在本文的实验中,Yale人脸数据集中每张图像的尺寸都被手动裁剪并调整为 32×32。Yale人脸数据集中某人的一些示例图像如图2 所示。

实验同样选取每个人的 i(i=4,5)个样本进行训练,其余样本用于测试。对于每个给定的i,笔者执行10次随机选择样本操作并训练样本,然后计算平均识别率和标准偏差,结果见表2 。其中,LRC的性能较差,SRC、CRC与CRC/MCCLC的性能较好, CRC/MCCLC的性能比SRC和CRC更好。

图2

4.3 AR人脸数据集上的实验

AR人脸数据集包含126个人的不同面部表情、光照条件和遮挡情况下的 4 000 多张灰色人脸图像。在本文的实验中,所有图像的尺寸都被手动裁剪并调整为50×40。

笔者在AR人脸数据集上进行了两个实验。在第一个实验中,笔者使用了AR人脸数据集的子集,其中包含来自120个人的1 680张图像。对于每个人,AR人脸数据集中会话1中的7张图像用于训练,而会话2中的7张图像用于测试。AR人脸数据集中某人的一些示例图像如图3 所示。PCA被用于将每张图像的维数降低到 300。不同算法在 AR人脸数据集上不同聚类量的平均识别率见表3 。

在第二个实验中,笔者使用了AR人脸数据集的其他子集,包含来自120个人的1 440张图像。其中,960张无遮挡图像(每个人约8张图像)用于训练,其余戴墨镜和围巾的图像(如图4 所示)用于测试。PCA 被用于将每张图像的维数降低到300。不同算法在AR人脸数据集上不同聚类量的墨镜/围巾遮挡识别率分别见表4 和表5 。

总体看来,除LRC外的几种算法有较好的实验表现,这些算法在AR数据集以及其墨镜遮挡数据集上展现出的性能不分伯仲,但 CRC/MCCLC 在围巾遮挡数据集上的表现明显优于其他算法。

图3

图4

4.4 参数敏感性

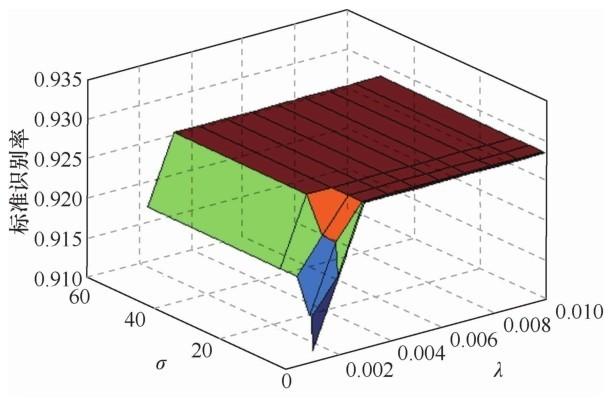

核大小σ和正则化参数λ都是重要参数,经过良好调整的σ和λ可以提高CRC/MCCLC的性能。在本节中,笔者将研究σ和λ对CRC/MCCLC的识别性能的影响,实验的数据集合为{0.1, 0.5, 1, 5, 10, 50}和{0.001, 0.002, 0.003, 0.004, 0.005, 0.006, 0.007,0.008, 0.009, 0.010}。 在ORL人脸数据集上,σ和λ对 CRC/MCCLC 的识别性能的影响如图5 所示(实验时每个人都有4个样本用于训练)。

图5

4.5 讨论

(1)与其他方法相比,本文提出的CRC/MCCLC在大多数实验中可以达到最高的平均识别率。然而,CRC/MCCLC在所有实验中并不总是显著优于SRC、CRC、LRC和CESR的。

(2)从第4.4节的实验可以看出,CRC/MCCLC的识别性能取决于σ和λ。然而,当σ和λ分别从集合{0.1, 0.5, 1, 5, 10, 50} 和 {0.001, 0.002, 0.003, 0.004, 0.005, 0.006, 0.007, 0.008, 0.009, 0.010}中取值时,CRC/MCCLC 的性能相对稳定。在实践中,研究人员可以使用交叉验证方法进行选择,这是因为可以获得最高识别率的最佳σ和λ以及最高识别率取决于测试数据,并且在实际问题中事先未知。

5 结束语

本文提出了一种新的基于最大相关熵和局部约束的协同表示分类器CRC/MCCLC。借助最大相关熵准则的优势,CRC/MCCLC对异常值的鲁棒性比L1 范数更高,而且可以使用半二次优化技术进行有效的计算。同时,CRC/MCCLC对局部信息的使用使得其可以从训练样本中获得更多的判别信息及近似稀疏表示。这些方法的运用使得CRC/MCCLC可以获得较好的性能。

参考文献

View Option

[1]

GU B , SHENG V S . A robust regularization path algorithm for v-support vector classification

[J]. IEEE Transactions on Neural Networks and Learning Systems , 2017 ,28 (5 ): 1241 -1248 .

[本文引用: 1]

[2]

GU B , SUN X M , SHENG V S . Structural minimax probability machine

[J]. IEEE Transactions on Neural Networks and Learning Systems , 2017 ,28 (7 ): 1646 -1656 .

[本文引用: 1]

[3]

LIU Y F , CHEN J H . Unsupervised face frontalization for pose-invariant face recognition

[J]. Image and Vision Computing , 2021 ,106 : 104093 .

[本文引用: 1]

[4]

TANG L L , LU H F , PANG Z ,et al . A distance weighted linear regression classifier based on optimized distance calculating approach for face recognition

[J]. Multimedia Tools and Applications , 2019 ,78 (22 ): 32485 -32501 .

[本文引用: 1]

[5]

WEN X Z , SHAO L , XUE Y ,et al . A rapid learning algorithm for vehicle classification

[J]. Information Sciences , 2015 ,295 : 395 -406 .

[本文引用: 1]

[6]

ZHOU Z L , WANG Y L , WU Q M J ,et al . Effective and efficient global context verification for image copy detection

[J]. IEEE Transactions on Information Forensics and Security , 2017 ,12 (1 ): 48 -63 .

[本文引用: 1]

[7]

沈宇 , 韩金朋 , 李灵犀 ,等 . 游戏智能中的 AI:从多角色博弈到平行博弈

[J]. 智能科学与技术学报 , 2020 ,2 (3 ): 205 -213 .

[本文引用: 1]

SHEN Y , HAN J P , LI L X ,et al . AI in game intelligence-from multi-role game to parallel game

[J]. Chinese Journal of Intelligent Science and Technology , 2020 ,2 (3 ): 205 -213 .

[本文引用: 1]

[8]

韩冬 , 李其花 , 蔡巍 ,等 . 人工智能在医学影像中的研究与应用

[J]. 大数据 , 2019 ,5 (1 ): 39 -67 .

[本文引用: 1]

HAN D , LI Q H , CAI W ,et al . Research and application of artificial intelligence in medical imaging

[J]. Big Data Research , 2019 ,5 (1 ): 39 -67 .

[本文引用: 1]

[9]

TURK M , PENTLAND A . Eigenfaces for recognition

[J]. Journal of Cognitive Neuroscience , 1991 ,3 (1 ): 71 -86 .

[本文引用: 1]

[10]

BELHUMEUR P N , HESPANHA J P , KRIEGMAN D J . Eigenfaces vs.Fisherfaces:recognition using class specific linear projection

[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence , 1997 ,19 (7 ): 711 -720 .

[本文引用: 1]

[11]

KIM J , CHOI J , YI J ,et al . Effective representation using ICA for face recognition robust to local distortion and partial occlusion

[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence , 2005 ,27 (12 ): 1977 -1981 .

[本文引用: 1]

[12]

HE X F , YAN S C , HU Y X ,et al . Face recognition using Laplacianfaces

[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence , 2005 ,27 (3 ): 328 -340 .

[本文引用: 2]

[13]

LI S Z , LU J W . Face recognition using the nearest feature line method

[J]. IEEE Transactions on Neural Networks , 1999 ,10 (2 ): 439 -443 .

[本文引用: 1]

[14]

LI S Z , CHAN K L , WANG C L . Performance evaluation of the nearest feature line method in image classification and retrieval

[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence , 2000 ,22 (11 ): 1335 -1339 .

[本文引用: 1]

[15]

CHIEN J T , WU C C . Discriminant waveletfaces and nearest feature classifiers for face recognition

[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence , 2002 ,24 (12 ): 1644 -1649 .

[本文引用: 1]

[16]

WRIGHT J , YANG A Y , GANESH A ,et al . Robust face recognition via sparse representation

[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence , 2009 ,31 (2 ): 210 -227 .

[本文引用: 4]

[17]

NASEEM I , TOGNERI R , BENNAMOUN M . Linear regression for face recognition

[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence , 2010 ,32 (11 ): 2106 -2112 .

[本文引用: 3]

[18]

NASEEM I , TOGNERI R , BENNAMOUN M . Robust regression for face recognition

[J]. Pattern Recognition , 2012 ,45 (1 ): 104 -118 .

[本文引用: 1]

[19]

REN C X , DAI D Q , YAN H . Robust classification using L2,1 -norm based regression model

[J]. Pattern Recognition , 2012 ,45 (7 ): 2708 -2718 .

[本文引用: 3]

[20]

SHEN F M , TANG Z M , XU J S . Locality constrained representation based classification with spatial pyramid patches

[J]. Neurocomputing , 2013 ,101 : 104 -115 .

[本文引用: 1]

[21]

ZHANG L , YANG M , FENG X C . Sparse representation or collaborative representation:which helps face recognition?

[C]// Proceedings of the IEEE 2011 International Conference on Computer Vision . Piscataway:IEEE Press , 2011 : 471 -478 .

[本文引用: 5]

[22]

HE R , ZHENG W S , HU B G . Maximum correntropy criterion for robust face recognition

[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence , 2011 ,33 (8 ): 1561 -1576 .

[本文引用: 4]

[23]

ZHOU Z H , WAGNER A , MOBAHI H ,et al . Face recognition with contiguous occlusion using Markov random fields

[C]// Proceedings of the 2009 IEEE 12th International Conference on Computer Vision . Piscataway:IEEE Press , 2009 : 1050 -1057 .

[本文引用: 1]

[24]

LIU W F , POKHAREL P P , PRINCIPE J C . Correntropy:properties and applications in non-Gaussian signal processing

[J]. IEEE Transactions on Signal Processing , 2007 ,55 (11 ): 5286 -5298 .

[本文引用: 3]

[25]

SANTAMARIA I , POKHAREL P P , PRINCIPE J C . Generalized correlation function:definition,properties,and application to blind equalization

[J]. IEEE Transactions on Signal Processing , 2006 ,54 (6 ): 2187 -2197 .

[本文引用: 2]

[26]

JEONG K H , LIU W F , HAN S ,et al . The correntropy MACE filter

[J]. Pattern Recognition , 2009 ,42 (5 ): 871 -885 .

[本文引用: 1]

[27]

YUAN X T , HU B G . Robust feature extraction via information theoretic learning

[C]// Proceedings of the 26th Annual International Conference on Machine Learning . New York:ACM Press , 2009 : 1193 -1200 .

[本文引用: 3]

[28]

SHI Q , ERIKSSON A , HENGEL A V D ,et al . Is face recognition really a compressive sensing problem?

[C]// Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition . Piscataway:IEEE Press , 2011 : 553 -560 .

[本文引用: 1]

[29]

NIE F P , HUANG H , CAI X ,et al . Efcient and robust feature selection via joint L2,1 -norms minimization

[C]// Proceedings of the 23rd International Conference on Neural Information Processing Systems . Piscataway:IEEE Press , 2010 : 1813 -1821 .

[本文引用: 1]

[30]

TENENBAUM J B , DE SILVA V , LANGFORD J C . A global geometric framework for nonlinear dimensionality reduction

[J]. Science , 2000 ,290 (5500 ): 2319 -2323 .

[本文引用: 1]

[31]

ROWEIS S T . Nonlinear dimensionality reduction by locally linear embedding

[J]. Science , 2000 ,290 (5500 ): 2323 -2326 .

[本文引用: 1]

[32]

BELKIN M , NIYOGI P . Laplacian eigenmaps for dimensionality reduction and data representation

[J]. Neural Computation , 2003 ,15 (6 ): 1373 -1396 .

[本文引用: 1]

[33]

YAN S C , XU D , ZHANG B ,et al . Graph embedding and extensions:a general framework for dimensionality reduction

[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence , 2007 ,29 (1 ): 40 -51 .

[本文引用: 1]

[34]

ZHANG L Y , DENNEY B , LU J W . A collaborative approach for face verification and attributes refinement

[J]. Information Sciences , 2014 ,281 : 620 -634 .

[本文引用: 1]

[35]

LIU F , TANG J H , SONG Y ,et al . Local structure based multi-phase collaborative representation for face recognition with single sample per person

[J]. Information Sciences , 2016 ,346/347 : 198 -215 .

[本文引用: 1]

[36]

ZHENG Z L , HUANG X Q , CHEN Z Y ,et al . Regression analysis of locality preserving projections via sparse penalty

[J]. Information Sciences , 2015 ,303 : 1 -14 .

[本文引用: 1]

[37]

DORNAIKA F , BOSAGHZADEH A . Adaptive graph construction using data self-representativeness for pattern classification

[J]. Information Sciences , 2015 ,325 : 118 -139 .

[本文引用: 1]

[38]

YU K , ZHANG T , GONG Y H . Nonlinear learning using local coordinate coding

[C]// Proceedings of the Advances in Neural Information Processing Systems .[S.l.:s.n.], 2009 : 2223 -2231 .

[本文引用: 2]

[39]

WANG J J , YANG J C , YU K ,et al . Locality-constrained linear coding for image classification

[C]// Proceedings of the 2010 IEEE Computer Society Conference on Computer Vision and Pattern Recognition . Piscataway:IEEE Press , 2010 : 3360 -3367 .

[本文引用: 1]

A robust regularization path algorithm for v-support vector classification

1

2017

... 人脸识别因其巨大的应用潜力吸引了计算机视觉、机器学习和模式识别领域的大量研究人员,在过去的二十年中诞生了许多算法[1 ,2 ,3 ,4 ,5 ,6 ,7 ,8 ] .一些众所周知的人脸识别方法,例如基于主成分分析(principal component analysis,PCA)的Eigenfaces[9 ] 、基于线性判别分析(linear discriminant analysis,LDA)的Fisherfaces[10 ] 、基于独立成分分析(independent component analysis,ICA)的Independentfaces[11 ] 和基于局部保留投影(locality preserving projection, LPP)的Laplacianfaces[12 ] ,已经获得了较好的成果,然而这些方法对噪声和异常值很敏感. ...

Structural minimax probability machine

1

2017

... 人脸识别因其巨大的应用潜力吸引了计算机视觉、机器学习和模式识别领域的大量研究人员,在过去的二十年中诞生了许多算法[1 ,2 ,3 ,4 ,5 ,6 ,7 ,8 ] .一些众所周知的人脸识别方法,例如基于主成分分析(principal component analysis,PCA)的Eigenfaces[9 ] 、基于线性判别分析(linear discriminant analysis,LDA)的Fisherfaces[10 ] 、基于独立成分分析(independent component analysis,ICA)的Independentfaces[11 ] 和基于局部保留投影(locality preserving projection, LPP)的Laplacianfaces[12 ] ,已经获得了较好的成果,然而这些方法对噪声和异常值很敏感. ...

Unsupervised face frontalization for pose-invariant face recognition

1

2021

... 人脸识别因其巨大的应用潜力吸引了计算机视觉、机器学习和模式识别领域的大量研究人员,在过去的二十年中诞生了许多算法[1 ,2 ,3 ,4 ,5 ,6 ,7 ,8 ] .一些众所周知的人脸识别方法,例如基于主成分分析(principal component analysis,PCA)的Eigenfaces[9 ] 、基于线性判别分析(linear discriminant analysis,LDA)的Fisherfaces[10 ] 、基于独立成分分析(independent component analysis,ICA)的Independentfaces[11 ] 和基于局部保留投影(locality preserving projection, LPP)的Laplacianfaces[12 ] ,已经获得了较好的成果,然而这些方法对噪声和异常值很敏感. ...

A distance weighted linear regression classifier based on optimized distance calculating approach for face recognition

1

2019

... 人脸识别因其巨大的应用潜力吸引了计算机视觉、机器学习和模式识别领域的大量研究人员,在过去的二十年中诞生了许多算法[1 ,2 ,3 ,4 ,5 ,6 ,7 ,8 ] .一些众所周知的人脸识别方法,例如基于主成分分析(principal component analysis,PCA)的Eigenfaces[9 ] 、基于线性判别分析(linear discriminant analysis,LDA)的Fisherfaces[10 ] 、基于独立成分分析(independent component analysis,ICA)的Independentfaces[11 ] 和基于局部保留投影(locality preserving projection, LPP)的Laplacianfaces[12 ] ,已经获得了较好的成果,然而这些方法对噪声和异常值很敏感. ...

A rapid learning algorithm for vehicle classification

1

2015

... 人脸识别因其巨大的应用潜力吸引了计算机视觉、机器学习和模式识别领域的大量研究人员,在过去的二十年中诞生了许多算法[1 ,2 ,3 ,4 ,5 ,6 ,7 ,8 ] .一些众所周知的人脸识别方法,例如基于主成分分析(principal component analysis,PCA)的Eigenfaces[9 ] 、基于线性判别分析(linear discriminant analysis,LDA)的Fisherfaces[10 ] 、基于独立成分分析(independent component analysis,ICA)的Independentfaces[11 ] 和基于局部保留投影(locality preserving projection, LPP)的Laplacianfaces[12 ] ,已经获得了较好的成果,然而这些方法对噪声和异常值很敏感. ...

Effective and efficient global context verification for image copy detection

1

2017

... 人脸识别因其巨大的应用潜力吸引了计算机视觉、机器学习和模式识别领域的大量研究人员,在过去的二十年中诞生了许多算法[1 ,2 ,3 ,4 ,5 ,6 ,7 ,8 ] .一些众所周知的人脸识别方法,例如基于主成分分析(principal component analysis,PCA)的Eigenfaces[9 ] 、基于线性判别分析(linear discriminant analysis,LDA)的Fisherfaces[10 ] 、基于独立成分分析(independent component analysis,ICA)的Independentfaces[11 ] 和基于局部保留投影(locality preserving projection, LPP)的Laplacianfaces[12 ] ,已经获得了较好的成果,然而这些方法对噪声和异常值很敏感. ...

游戏智能中的 AI:从多角色博弈到平行博弈

1

2020

... 人脸识别因其巨大的应用潜力吸引了计算机视觉、机器学习和模式识别领域的大量研究人员,在过去的二十年中诞生了许多算法[1 ,2 ,3 ,4 ,5 ,6 ,7 ,8 ] .一些众所周知的人脸识别方法,例如基于主成分分析(principal component analysis,PCA)的Eigenfaces[9 ] 、基于线性判别分析(linear discriminant analysis,LDA)的Fisherfaces[10 ] 、基于独立成分分析(independent component analysis,ICA)的Independentfaces[11 ] 和基于局部保留投影(locality preserving projection, LPP)的Laplacianfaces[12 ] ,已经获得了较好的成果,然而这些方法对噪声和异常值很敏感. ...

游戏智能中的 AI:从多角色博弈到平行博弈

1

2020

... 人脸识别因其巨大的应用潜力吸引了计算机视觉、机器学习和模式识别领域的大量研究人员,在过去的二十年中诞生了许多算法[1 ,2 ,3 ,4 ,5 ,6 ,7 ,8 ] .一些众所周知的人脸识别方法,例如基于主成分分析(principal component analysis,PCA)的Eigenfaces[9 ] 、基于线性判别分析(linear discriminant analysis,LDA)的Fisherfaces[10 ] 、基于独立成分分析(independent component analysis,ICA)的Independentfaces[11 ] 和基于局部保留投影(locality preserving projection, LPP)的Laplacianfaces[12 ] ,已经获得了较好的成果,然而这些方法对噪声和异常值很敏感. ...

人工智能在医学影像中的研究与应用

1

2019

... 人脸识别因其巨大的应用潜力吸引了计算机视觉、机器学习和模式识别领域的大量研究人员,在过去的二十年中诞生了许多算法[1 ,2 ,3 ,4 ,5 ,6 ,7 ,8 ] .一些众所周知的人脸识别方法,例如基于主成分分析(principal component analysis,PCA)的Eigenfaces[9 ] 、基于线性判别分析(linear discriminant analysis,LDA)的Fisherfaces[10 ] 、基于独立成分分析(independent component analysis,ICA)的Independentfaces[11 ] 和基于局部保留投影(locality preserving projection, LPP)的Laplacianfaces[12 ] ,已经获得了较好的成果,然而这些方法对噪声和异常值很敏感. ...

人工智能在医学影像中的研究与应用

1

2019

... 人脸识别因其巨大的应用潜力吸引了计算机视觉、机器学习和模式识别领域的大量研究人员,在过去的二十年中诞生了许多算法[1 ,2 ,3 ,4 ,5 ,6 ,7 ,8 ] .一些众所周知的人脸识别方法,例如基于主成分分析(principal component analysis,PCA)的Eigenfaces[9 ] 、基于线性判别分析(linear discriminant analysis,LDA)的Fisherfaces[10 ] 、基于独立成分分析(independent component analysis,ICA)的Independentfaces[11 ] 和基于局部保留投影(locality preserving projection, LPP)的Laplacianfaces[12 ] ,已经获得了较好的成果,然而这些方法对噪声和异常值很敏感. ...

Eigenfaces for recognition

1

1991

... 人脸识别因其巨大的应用潜力吸引了计算机视觉、机器学习和模式识别领域的大量研究人员,在过去的二十年中诞生了许多算法[1 ,2 ,3 ,4 ,5 ,6 ,7 ,8 ] .一些众所周知的人脸识别方法,例如基于主成分分析(principal component analysis,PCA)的Eigenfaces[9 ] 、基于线性判别分析(linear discriminant analysis,LDA)的Fisherfaces[10 ] 、基于独立成分分析(independent component analysis,ICA)的Independentfaces[11 ] 和基于局部保留投影(locality preserving projection, LPP)的Laplacianfaces[12 ] ,已经获得了较好的成果,然而这些方法对噪声和异常值很敏感. ...

Eigenfaces vs.Fisherfaces:recognition using class specific linear projection

1

1997

... 人脸识别因其巨大的应用潜力吸引了计算机视觉、机器学习和模式识别领域的大量研究人员,在过去的二十年中诞生了许多算法[1 ,2 ,3 ,4 ,5 ,6 ,7 ,8 ] .一些众所周知的人脸识别方法,例如基于主成分分析(principal component analysis,PCA)的Eigenfaces[9 ] 、基于线性判别分析(linear discriminant analysis,LDA)的Fisherfaces[10 ] 、基于独立成分分析(independent component analysis,ICA)的Independentfaces[11 ] 和基于局部保留投影(locality preserving projection, LPP)的Laplacianfaces[12 ] ,已经获得了较好的成果,然而这些方法对噪声和异常值很敏感. ...

Effective representation using ICA for face recognition robust to local distortion and partial occlusion

1

2005

... 人脸识别因其巨大的应用潜力吸引了计算机视觉、机器学习和模式识别领域的大量研究人员,在过去的二十年中诞生了许多算法[1 ,2 ,3 ,4 ,5 ,6 ,7 ,8 ] .一些众所周知的人脸识别方法,例如基于主成分分析(principal component analysis,PCA)的Eigenfaces[9 ] 、基于线性判别分析(linear discriminant analysis,LDA)的Fisherfaces[10 ] 、基于独立成分分析(independent component analysis,ICA)的Independentfaces[11 ] 和基于局部保留投影(locality preserving projection, LPP)的Laplacianfaces[12 ] ,已经获得了较好的成果,然而这些方法对噪声和异常值很敏感. ...

Face recognition using Laplacianfaces

2

2005

... 人脸识别因其巨大的应用潜力吸引了计算机视觉、机器学习和模式识别领域的大量研究人员,在过去的二十年中诞生了许多算法[1 ,2 ,3 ,4 ,5 ,6 ,7 ,8 ] .一些众所周知的人脸识别方法,例如基于主成分分析(principal component analysis,PCA)的Eigenfaces[9 ] 、基于线性判别分析(linear discriminant analysis,LDA)的Fisherfaces[10 ] 、基于独立成分分析(independent component analysis,ICA)的Independentfaces[11 ] 和基于局部保留投影(locality preserving projection, LPP)的Laplacianfaces[12 ] ,已经获得了较好的成果,然而这些方法对噪声和异常值很敏感. ...

... 流形学习的成功表明局部几何信息对构建学习算法非常重要[12 ,30 ,31 ,32 ,33 ,34 ,35 ,36 ,37 ,38 ] .参考文献[38 -39 ]认为局部性比稀疏性更重要,这是因为局部性总会导致稀疏性,但反过来不一定成立.在局部约束下,L2范数也可以产生近似稀疏的表示结果. ...

Face recognition using the nearest feature line method

1

1999

... Li S Z等人[13 ] 提出了一种最近特征线(nearest feature line,NFL)分类方法,该方法使用线性方式对属于同一类的每对训练样本进行外推和内插.NFL可以泛化样本的代表性能力,并已被广泛应用于许多模式识别任务中[14 ] .沿着这个研究方向, Chien J T等人[15 ] 提出了一种最近特征空间(nearest feature space,NFS)分类方法.NFS中构建每个类的特征空间的方式与NFL中构建特征线的方式类似. ...

Performance evaluation of the nearest feature line method in image classification and retrieval

1

2000

... Li S Z等人[13 ] 提出了一种最近特征线(nearest feature line,NFL)分类方法,该方法使用线性方式对属于同一类的每对训练样本进行外推和内插.NFL可以泛化样本的代表性能力,并已被广泛应用于许多模式识别任务中[14 ] .沿着这个研究方向, Chien J T等人[15 ] 提出了一种最近特征空间(nearest feature space,NFS)分类方法.NFS中构建每个类的特征空间的方式与NFL中构建特征线的方式类似. ...

Discriminant waveletfaces and nearest feature classifiers for face recognition

1

2002

... Li S Z等人[13 ] 提出了一种最近特征线(nearest feature line,NFL)分类方法,该方法使用线性方式对属于同一类的每对训练样本进行外推和内插.NFL可以泛化样本的代表性能力,并已被广泛应用于许多模式识别任务中[14 ] .沿着这个研究方向, Chien J T等人[15 ] 提出了一种最近特征空间(nearest feature space,NFS)分类方法.NFS中构建每个类的特征空间的方式与NFL中构建特征线的方式类似. ...

Robust face recognition via sparse representation

4

2009

... 近年来,研究人员们在假设测试图像位于由同一类图像组成的线性子空间的条件下,提出了一些基于线性表示的新型分类算法[16 ,17 ,18 ,19 ,20 ,21 ,22 ] .Wright J 等人[16 ] 提出了一种基于稀疏表示的分类器 SRC(sparse representation classifier),SRC在人脸识别方面取得了较好的结果.SRC使用所有训练样本来制定一个过完备字典,然后通过L1 最小化问题在训练样本上对探测图像进行稀疏编码.SRC得到的大部分组合系数很小,接近于零,只有小部分组合系数具有显著值,因此可以使用非零系数来确定探测图像的标签. ...

... [16 ]提出了一种基于稀疏表示的分类器 SRC(sparse representation classifier),SRC在人脸识别方面取得了较好的结果.SRC使用所有训练样本来制定一个过完备字典,然后通过L1 最小化问题在训练样本上对探测图像进行稀疏编码.SRC得到的大部分组合系数很小,接近于零,只有小部分组合系数具有显著值,因此可以使用非零系数来确定探测图像的标签. ...

... SRC[16 ] 试图用式(3)求解稀疏解: ...

... 本节在人脸识别方面将本文提出的 CRC/MCCLC与几种相关的先进算法进行比较,如SRC[16 ] 、CRC[21 ] 、LRC[17 ] 以及CESR[22 ] .SRC是使用l1-magic实现的,是一个公开可用的数据包.对于CRC/MCCLC中的σ和λ,笔者尝试从{0.1, 0.5, 1, 5, 10, 50}与{0.001, 0.002, 0.003, 0.004, 0.005, 0.006, 0.007, 0.008, 0.009, 0.010}中分别取不同的值进行测试.实验是在移动双核Intel Pentium(1.8 GHz)处理器、4G RAM的acer计算机上进行的,实验所用操作系统为Windows7,编程环境为MATLAB2008. ...

Linear regression for face recognition

3

2010

... 近年来,研究人员们在假设测试图像位于由同一类图像组成的线性子空间的条件下,提出了一些基于线性表示的新型分类算法[16 ,17 ,18 ,19 ,20 ,21 ,22 ] .Wright J 等人[16 ] 提出了一种基于稀疏表示的分类器 SRC(sparse representation classifier),SRC在人脸识别方面取得了较好的结果.SRC使用所有训练样本来制定一个过完备字典,然后通过L1 最小化问题在训练样本上对探测图像进行稀疏编码.SRC得到的大部分组合系数很小,接近于零,只有小部分组合系数具有显著值,因此可以使用非零系数来确定探测图像的标签. ...

... 参考文献[17 ]提出了另一种同样使用L2 范数的有效的基于线性回归的分类方法 LRC(linear regression-based classification).与 CRC 相比,LRC仅使用来自特定类别的图像获取表示系数.Ren C X等人[19 ] 提出了一种基于L2,1 范数的分类方法,称为基于旋转不变范数的回归分类(rotational inva riant norm based regression for classification,RRC)方法,L2,1 范数是旋转不变的,且比 L2 范数对噪声和异常值的处理更具鲁棒性.Ren C X 等人[19 ] 还为RRC开发了一种高效的优化算法,这与Nie F P等人[29 ] 提出的优化算法非常相似. ...

... 本节在人脸识别方面将本文提出的 CRC/MCCLC与几种相关的先进算法进行比较,如SRC[16 ] 、CRC[21 ] 、LRC[17 ] 以及CESR[22 ] .SRC是使用l1-magic实现的,是一个公开可用的数据包.对于CRC/MCCLC中的σ和λ,笔者尝试从{0.1, 0.5, 1, 5, 10, 50}与{0.001, 0.002, 0.003, 0.004, 0.005, 0.006, 0.007, 0.008, 0.009, 0.010}中分别取不同的值进行测试.实验是在移动双核Intel Pentium(1.8 GHz)处理器、4G RAM的acer计算机上进行的,实验所用操作系统为Windows7,编程环境为MATLAB2008. ...

Robust regression for face recognition

1

2012

... 近年来,研究人员们在假设测试图像位于由同一类图像组成的线性子空间的条件下,提出了一些基于线性表示的新型分类算法[16 ,17 ,18 ,19 ,20 ,21 ,22 ] .Wright J 等人[16 ] 提出了一种基于稀疏表示的分类器 SRC(sparse representation classifier),SRC在人脸识别方面取得了较好的结果.SRC使用所有训练样本来制定一个过完备字典,然后通过L1 最小化问题在训练样本上对探测图像进行稀疏编码.SRC得到的大部分组合系数很小,接近于零,只有小部分组合系数具有显著值,因此可以使用非零系数来确定探测图像的标签. ...

Robust classification using L2,1 -norm based regression model

3

2012

... 近年来,研究人员们在假设测试图像位于由同一类图像组成的线性子空间的条件下,提出了一些基于线性表示的新型分类算法[16 ,17 ,18 ,19 ,20 ,21 ,22 ] .Wright J 等人[16 ] 提出了一种基于稀疏表示的分类器 SRC(sparse representation classifier),SRC在人脸识别方面取得了较好的结果.SRC使用所有训练样本来制定一个过完备字典,然后通过L1 最小化问题在训练样本上对探测图像进行稀疏编码.SRC得到的大部分组合系数很小,接近于零,只有小部分组合系数具有显著值,因此可以使用非零系数来确定探测图像的标签. ...

... 参考文献[17 ]提出了另一种同样使用L2 范数的有效的基于线性回归的分类方法 LRC(linear regression-based classification).与 CRC 相比,LRC仅使用来自特定类别的图像获取表示系数.Ren C X等人[19 ] 提出了一种基于L2,1 范数的分类方法,称为基于旋转不变范数的回归分类(rotational inva riant norm based regression for classification,RRC)方法,L2,1 范数是旋转不变的,且比 L2 范数对噪声和异常值的处理更具鲁棒性.Ren C X 等人[19 ] 还为RRC开发了一种高效的优化算法,这与Nie F P等人[29 ] 提出的优化算法非常相似. ...

... [19 ]还为RRC开发了一种高效的优化算法,这与Nie F P等人[29 ] 提出的优化算法非常相似. ...

Locality constrained representation based classification with spatial pyramid patches

1

2013

... 近年来,研究人员们在假设测试图像位于由同一类图像组成的线性子空间的条件下,提出了一些基于线性表示的新型分类算法[16 ,17 ,18 ,19 ,20 ,21 ,22 ] .Wright J 等人[16 ] 提出了一种基于稀疏表示的分类器 SRC(sparse representation classifier),SRC在人脸识别方面取得了较好的结果.SRC使用所有训练样本来制定一个过完备字典,然后通过L1 最小化问题在训练样本上对探测图像进行稀疏编码.SRC得到的大部分组合系数很小,接近于零,只有小部分组合系数具有显著值,因此可以使用非零系数来确定探测图像的标签. ...

Sparse representation or collaborative representation:which helps face recognition?

5

2011

... 近年来,研究人员们在假设测试图像位于由同一类图像组成的线性子空间的条件下,提出了一些基于线性表示的新型分类算法[16 ,17 ,18 ,19 ,20 ,21 ,22 ] .Wright J 等人[16 ] 提出了一种基于稀疏表示的分类器 SRC(sparse representation classifier),SRC在人脸识别方面取得了较好的结果.SRC使用所有训练样本来制定一个过完备字典,然后通过L1 最小化问题在训练样本上对探测图像进行稀疏编码.SRC得到的大部分组合系数很小,接近于零,只有小部分组合系数具有显著值,因此可以使用非零系数来确定探测图像的标签. ...

... 然而,参考文献[28 ]认为SRC中用于约束的L1 范数可以用L2 范数代替,这是因为真实人脸图像不支持SRC的稀疏假设.同样,Zhang L等人[21 ] 认为协同表示的方法可以获得比使用L1 范数的SRC更好的结果.因此,Zhang L 等人[21 ] 提出了一种基于协同表示的分类方法 CRC(collaborative representation based classification),CRC使用L2 范数而获得了解析解,因此其展现出比SRC更优秀的性能. ...

... [21 ]提出了一种基于协同表示的分类方法 CRC(collaborative representation based classification),CRC使用L2 范数而获得了解析解,因此其展现出比SRC更优秀的性能. ...

... CRC[21 ] 仅用L2 范数代替式(6)中的L1 范数就可以得到较高的识别率.CRC的目标函数为: ...

... 本节在人脸识别方面将本文提出的 CRC/MCCLC与几种相关的先进算法进行比较,如SRC[16 ] 、CRC[21 ] 、LRC[17 ] 以及CESR[22 ] .SRC是使用l1-magic实现的,是一个公开可用的数据包.对于CRC/MCCLC中的σ和λ,笔者尝试从{0.1, 0.5, 1, 5, 10, 50}与{0.001, 0.002, 0.003, 0.004, 0.005, 0.006, 0.007, 0.008, 0.009, 0.010}中分别取不同的值进行测试.实验是在移动双核Intel Pentium(1.8 GHz)处理器、4G RAM的acer计算机上进行的,实验所用操作系统为Windows7,编程环境为MATLAB2008. ...

Maximum correntropy criterion for robust face recognition

4

2011

... 近年来,研究人员们在假设测试图像位于由同一类图像组成的线性子空间的条件下,提出了一些基于线性表示的新型分类算法[16 ,17 ,18 ,19 ,20 ,21 ,22 ] .Wright J 等人[16 ] 提出了一种基于稀疏表示的分类器 SRC(sparse representation classifier),SRC在人脸识别方面取得了较好的结果.SRC使用所有训练样本来制定一个过完备字典,然后通过L1 最小化问题在训练样本上对探测图像进行稀疏编码.SRC得到的大部分组合系数很小,接近于零,只有小部分组合系数具有显著值,因此可以使用非零系数来确定探测图像的标签. ...

... 尽管SRC在鲁棒人脸识别问题上非常成功,但对于存在连续遮挡的人脸图片,其鲁棒性仍然不够高[23 ] ,且计算复杂度非常高.为了解决这个问题, He R 等人[22 ] 提出了一种基于相关熵的稀疏表示(correntropy based sparse representation,CESR)方法.相关熵[24 -25 ] 与M估计(M-estimation)密切相关,可以有效地处理噪声和大的异常值[26 -27 ] .实验结果表明,对于人脸识别中的围巾遮挡问题,CESR的识别率高于SRC. ...

... 定理1[22 ,27 ] 存在g(x)的凸共轭函数ϕ使得: ...

... 本节在人脸识别方面将本文提出的 CRC/MCCLC与几种相关的先进算法进行比较,如SRC[16 ] 、CRC[21 ] 、LRC[17 ] 以及CESR[22 ] .SRC是使用l1-magic实现的,是一个公开可用的数据包.对于CRC/MCCLC中的σ和λ,笔者尝试从{0.1, 0.5, 1, 5, 10, 50}与{0.001, 0.002, 0.003, 0.004, 0.005, 0.006, 0.007, 0.008, 0.009, 0.010}中分别取不同的值进行测试.实验是在移动双核Intel Pentium(1.8 GHz)处理器、4G RAM的acer计算机上进行的,实验所用操作系统为Windows7,编程环境为MATLAB2008. ...

Face recognition with contiguous occlusion using Markov random fields

1

2009

... 尽管SRC在鲁棒人脸识别问题上非常成功,但对于存在连续遮挡的人脸图片,其鲁棒性仍然不够高[23 ] ,且计算复杂度非常高.为了解决这个问题, He R 等人[22 ] 提出了一种基于相关熵的稀疏表示(correntropy based sparse representation,CESR)方法.相关熵[24 -25 ] 与M估计(M-estimation)密切相关,可以有效地处理噪声和大的异常值[26 -27 ] .实验结果表明,对于人脸识别中的围巾遮挡问题,CESR的识别率高于SRC. ...

Correntropy:properties and applications in non-Gaussian signal processing

3

2007

... 尽管SRC在鲁棒人脸识别问题上非常成功,但对于存在连续遮挡的人脸图片,其鲁棒性仍然不够高[23 ] ,且计算复杂度非常高.为了解决这个问题, He R 等人[22 ] 提出了一种基于相关熵的稀疏表示(correntropy based sparse representation,CESR)方法.相关熵[24 -25 ] 与M估计(M-estimation)密切相关,可以有效地处理噪声和大的异常值[26 -27 ] .实验结果表明,对于人脸识别中的围巾遮挡问题,CESR的识别率高于SRC. ...

... 熵[24 -25 ] 被定义为两个任意变量A和B之间的局部相似性度量: ...

... 在参考文献[24 ]中,最大相关熵准则(maximum correntropy criterion,MCC)被定义为误差的最大相关熵. ...

Generalized correlation function:definition,properties,and application to blind equalization

2

2006

... 尽管SRC在鲁棒人脸识别问题上非常成功,但对于存在连续遮挡的人脸图片,其鲁棒性仍然不够高[23 ] ,且计算复杂度非常高.为了解决这个问题, He R 等人[22 ] 提出了一种基于相关熵的稀疏表示(correntropy based sparse representation,CESR)方法.相关熵[24 -25 ] 与M估计(M-estimation)密切相关,可以有效地处理噪声和大的异常值[26 -27 ] .实验结果表明,对于人脸识别中的围巾遮挡问题,CESR的识别率高于SRC. ...

... 熵[24 -25 ] 被定义为两个任意变量A和B之间的局部相似性度量: ...

The correntropy MACE filter

1

2009

... 尽管SRC在鲁棒人脸识别问题上非常成功,但对于存在连续遮挡的人脸图片,其鲁棒性仍然不够高[23 ] ,且计算复杂度非常高.为了解决这个问题, He R 等人[22 ] 提出了一种基于相关熵的稀疏表示(correntropy based sparse representation,CESR)方法.相关熵[24 -25 ] 与M估计(M-estimation)密切相关,可以有效地处理噪声和大的异常值[26 -27 ] .实验结果表明,对于人脸识别中的围巾遮挡问题,CESR的识别率高于SRC. ...

Robust feature extraction via information theoretic learning

3

2009

... 尽管SRC在鲁棒人脸识别问题上非常成功,但对于存在连续遮挡的人脸图片,其鲁棒性仍然不够高[23 ] ,且计算复杂度非常高.为了解决这个问题, He R 等人[22 ] 提出了一种基于相关熵的稀疏表示(correntropy based sparse representation,CESR)方法.相关熵[24 -25 ] 与M估计(M-estimation)密切相关,可以有效地处理噪声和大的异常值[26 -27 ] .实验结果表明,对于人脸识别中的围巾遮挡问题,CESR的识别率高于SRC. ...

... 由于 CRC/MCCLC 的求解是一个非线性优化问题,很难直接进行优化.因此,笔者设计了一种基于半二次优化技术求解式(12)的算法[27 ] . ...

... 定理1[22 ,27 ] 存在g(x)的凸共轭函数ϕ使得: ...

Is face recognition really a compressive sensing problem?

1

2011

... 然而,参考文献[28 ]认为SRC中用于约束的L1 范数可以用L2 范数代替,这是因为真实人脸图像不支持SRC的稀疏假设.同样,Zhang L等人[21 ] 认为协同表示的方法可以获得比使用L1 范数的SRC更好的结果.因此,Zhang L 等人[21 ] 提出了一种基于协同表示的分类方法 CRC(collaborative representation based classification),CRC使用L2 范数而获得了解析解,因此其展现出比SRC更优秀的性能. ...

Ef?cient and robust feature selection via joint L2,1 -norms minimization

1

2010

... 参考文献[17 ]提出了另一种同样使用L2 范数的有效的基于线性回归的分类方法 LRC(linear regression-based classification).与 CRC 相比,LRC仅使用来自特定类别的图像获取表示系数.Ren C X等人[19 ] 提出了一种基于L2,1 范数的分类方法,称为基于旋转不变范数的回归分类(rotational inva riant norm based regression for classification,RRC)方法,L2,1 范数是旋转不变的,且比 L2 范数对噪声和异常值的处理更具鲁棒性.Ren C X 等人[19 ] 还为RRC开发了一种高效的优化算法,这与Nie F P等人[29 ] 提出的优化算法非常相似. ...

A global geometric framework for nonlinear dimensionality reduction

1

2000

... 流形学习的成功表明局部几何信息对构建学习算法非常重要[12 ,30 ,31 ,32 ,33 ,34 ,35 ,36 ,37 ,38 ] .参考文献[38 -39 ]认为局部性比稀疏性更重要,这是因为局部性总会导致稀疏性,但反过来不一定成立.在局部约束下,L2范数也可以产生近似稀疏的表示结果. ...

Nonlinear dimensionality reduction by locally linear embedding

1

2000

... 流形学习的成功表明局部几何信息对构建学习算法非常重要[12 ,30 ,31 ,32 ,33 ,34 ,35 ,36 ,37 ,38 ] .参考文献[38 -39 ]认为局部性比稀疏性更重要,这是因为局部性总会导致稀疏性,但反过来不一定成立.在局部约束下,L2范数也可以产生近似稀疏的表示结果. ...

Laplacian eigenmaps for dimensionality reduction and data representation

1

2003

... 流形学习的成功表明局部几何信息对构建学习算法非常重要[12 ,30 ,31 ,32 ,33 ,34 ,35 ,36 ,37 ,38 ] .参考文献[38 -39 ]认为局部性比稀疏性更重要,这是因为局部性总会导致稀疏性,但反过来不一定成立.在局部约束下,L2范数也可以产生近似稀疏的表示结果. ...

Graph embedding and extensions:a general framework for dimensionality reduction

1

2007

... 流形学习的成功表明局部几何信息对构建学习算法非常重要[12 ,30 ,31 ,32 ,33 ,34 ,35 ,36 ,37 ,38 ] .参考文献[38 -39 ]认为局部性比稀疏性更重要,这是因为局部性总会导致稀疏性,但反过来不一定成立.在局部约束下,L2范数也可以产生近似稀疏的表示结果. ...

A collaborative approach for face verification and attributes refinement

1

2014

... 流形学习的成功表明局部几何信息对构建学习算法非常重要[12 ,30 ,31 ,32 ,33 ,34 ,35 ,36 ,37 ,38 ] .参考文献[38 -39 ]认为局部性比稀疏性更重要,这是因为局部性总会导致稀疏性,但反过来不一定成立.在局部约束下,L2范数也可以产生近似稀疏的表示结果. ...

Local structure based multi-phase collaborative representation for face recognition with single sample per person

1

2016

... 流形学习的成功表明局部几何信息对构建学习算法非常重要[12 ,30 ,31 ,32 ,33 ,34 ,35 ,36 ,37 ,38 ] .参考文献[38 -39 ]认为局部性比稀疏性更重要,这是因为局部性总会导致稀疏性,但反过来不一定成立.在局部约束下,L2范数也可以产生近似稀疏的表示结果. ...

Regression analysis of locality preserving projections via sparse penalty

1

2015

... 流形学习的成功表明局部几何信息对构建学习算法非常重要[12 ,30 ,31 ,32 ,33 ,34 ,35 ,36 ,37 ,38 ] .参考文献[38 -39 ]认为局部性比稀疏性更重要,这是因为局部性总会导致稀疏性,但反过来不一定成立.在局部约束下,L2范数也可以产生近似稀疏的表示结果. ...

Adaptive graph construction using data self-representativeness for pattern classification

1

2015

... 流形学习的成功表明局部几何信息对构建学习算法非常重要[12 ,30 ,31 ,32 ,33 ,34 ,35 ,36 ,37 ,38 ] .参考文献[38 -39 ]认为局部性比稀疏性更重要,这是因为局部性总会导致稀疏性,但反过来不一定成立.在局部约束下,L2范数也可以产生近似稀疏的表示结果. ...

Nonlinear learning using local coordinate coding

2

2009

... 流形学习的成功表明局部几何信息对构建学习算法非常重要[12 ,30 ,31 ,32 ,33 ,34 ,35 ,36 ,37 ,38 ] .参考文献[38 -39 ]认为局部性比稀疏性更重要,这是因为局部性总会导致稀疏性,但反过来不一定成立.在局部约束下,L2范数也可以产生近似稀疏的表示结果. ...

... .参考文献[38 -39 ]认为局部性比稀疏性更重要,这是因为局部性总会导致稀疏性,但反过来不一定成立.在局部约束下,L2范数也可以产生近似稀疏的表示结果. ...

Locality-constrained linear coding for image classification

1

2010

... 流形学习的成功表明局部几何信息对构建学习算法非常重要[12 ,30 ,31 ,32 ,33 ,34 ,35 ,36 ,37 ,38 ] .参考文献[38 -39 ]认为局部性比稀疏性更重要,这是因为局部性总会导致稀疏性,但反过来不一定成立.在局部约束下,L2范数也可以产生近似稀疏的表示结果. ...